Công nghệ cộng tác có thể được sử dụng để điều phối nguồn tài trợ trong bất kỳ lĩnh vực công nghệ nào khác

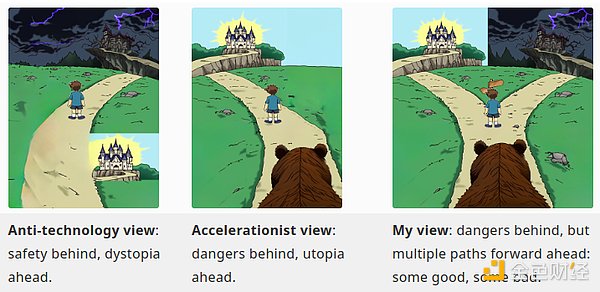

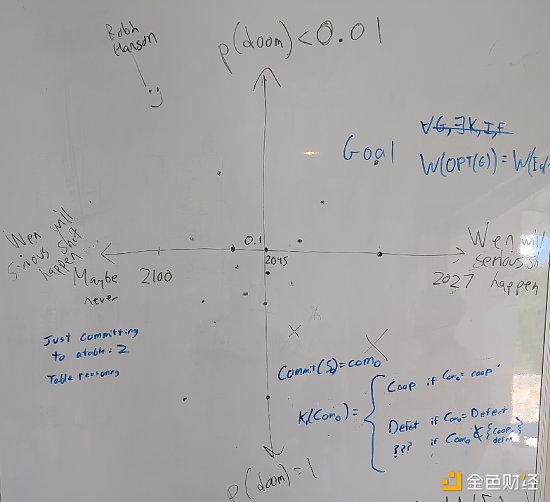

< /li>Tôi thấy rằng những phản đối thuyết phục nhất đối với bài viết của tôi năm ngoái là những lời chỉ trích từ cộng đồng an toàn AI. Lập luận đưa ra là: "Chắc chắn, nếu chúng ta có nửa thế kỷ để có được AI mạnh mẽ, chúng ta có thể tập trung vào việc xây dựng tất cả những thứ tốt đẹp này. Nhưng trên thực tế, có lẽ chúng ta vẫn còn ba năm nữa mới đạt được điều đó." AGI, siêu trí tuệ còn ba năm nữa mới xuất hiện. Vì vậy, nếu chúng ta không muốn thế giới bị hủy diệt hoặc mắc kẹt trong một cái bẫy không thể cứu vãn, chúng ta không thể tăng tốc những điều tốt đẹp, chúng ta phải làm chậm những điều xấu, và điều đó. có nghĩa là thông qua các quy định mạnh mẽ, có thể khiến những người có quyền lực khó chịu. Trong bài viết của tôi năm ngoái, tôi thực sự không kêu gọi bất kỳ chiến lược cụ thể nào để “làm chậm những điều tồi tệ xảy ra”, chỉ là một lời kêu gọi mơ hồ không xây dựng các siêu hình thức thông minh đầy rủi ro. . Vì vậy, ở đây, cần trả lời trực tiếp câu hỏi: nếu chúng ta sống trong một thế giới bất tiện nhất, nơi mà vai trò của AI rất cao và mốc thời gian có thể còn 5 năm nữa, tôi sẽ ủng hộ những quy định nào?

Năm ngoái, dự luật quản lý trí tuệ nhân tạo quan trọng nhất được đề xuất ở California là SB-1047. SB-1047 yêu cầu các nhà phát triển các mô hình mạnh nhất (những mô hình tốn hơn 100 triệu đô la để đào tạo hoặc hơn 10 triệu đô la để tinh chỉnh) phải thực hiện một số biện pháp kiểm tra bảo mật trước khi phát hành chúng. Hơn nữa, nó cũng khiến các nhà phát triển mô hình AI phải chịu trách nhiệm nếu họ không đủ cẩn thận. Nhiều nhà phê bình coi dự luật là một "mối đe dọa đối với nguồn mở"; tôi không đồng ý, vì ngưỡng chi phí có nghĩa là nó chỉ ảnh hưởng đến các mô hình mạnh nhất: ngay cả LLama3 cũng có khả năng giảm xuống dưới ngưỡng. Tuy nhiên, nhìn lại, tôi nghĩ dự luật có một vấn đề lớn hơn: Giống như hầu hết các đạo luật, nó đã được trang bị quá mức cho hoàn cảnh ngày nay. Trước các công nghệ mới, việc tập trung vào chi phí đào tạo đã trở nên mong manh: chi phí đào tạo gần đây của mẫu Deepseek v3 tiên tiến nhất chỉ là 6 triệu đô la Mỹ, trong khi ở các mô hình như Trong các mô hình mới như o1, chi phí đang chuyển từ đào tạo sang suy luận tổng quát hơn.

Thứ hai, các tác nhân có nhiều khả năng thực sự phải chịu trách nhiệm về kịch bản phá hủy siêu trí tuệ nhân tạo thực ra là quân đội. Như chúng ta đã thấy về an toàn sinh học trong nửa thế kỷ qua (và hơn thế nữa), quân đội sẵn sàng làm những điều khủng khiếp và họ dễ mắc sai lầm. Các ứng dụng quân sự của trí tuệ nhân tạo đang phát triển nhanh chóng (xem Ukraine, Gaza). Bất kỳ quy định an ninh nào mà chính phủ thông qua sẽ tự động miễn trừ quân đội của chính họ và các công ty hợp tác chặt chẽ với quân đội.

Tuy nhiên, những lập luận này không phải là lý do để bỏ cuộc và không hành động. Thay vào đó, chúng ta có thể sử dụng nó như một hướng dẫn và cố gắng đưa ra các quy tắc để giảm thiểu những mối lo ngại đó.

Nếu hành động của ai đó gây ra tổn hại có thể bị kiện về mặt pháp lý, họ có thể bị kiện. Điều này không giải quyết được vấn đề rủi ro từ quân đội và các chủ thể "trên pháp luật" khác, nhưng nó là một cách tiếp cận rất chung chung để tránh trang bị quá mức và thường bị chỉ trích bởi các xu hướng tự do vì lý do này.

Người dùng - những người sử dụng trí tuệ nhân tạo

Người triển khai - người trung gian cung cấp dịch vụ AI cho người dùng

Nhà phát triển - người xây dựng trí tuệ nhân tạo

Cho phép người dùng chịu trách nhiệm dường như phục vụ tốt nhất cho cơ cấu khuyến khích. Mặc dù mối liên hệ giữa cách một mô hình được phát triển và cách nó được sử dụng cuối cùng thường không rõ ràng, nhưng người dùng sẽ xác định chính xác cách sử dụng AI. Việc yêu cầu người dùng có trách nhiệm sẽ gây áp lực mạnh mẽ lên AI để phát triển theo cách mà tôi nghĩ là đúng đắn: tập trung vào việc xây dựng bộ đồ cơ khí cho tâm trí con người thay vì tạo ra các dạng sống thông minh tự duy trì mới. Cái trước đáp ứng ý định của người dùng một cách thường xuyên và do đó không dẫn đến hành vi thảm khốc trừ khi người dùng mong muốn điều đó. Loại thứ hai rất có thể vượt khỏi tầm kiểm soát và gây ra kịch bản "mất kiểm soát trí tuệ nhân tạo" điển hình. Một lợi ích khác của việc đặt trách nhiệm pháp lý càng gần địa điểm sử dụng cuối càng tốt là nó giảm thiểu rủi ro trách nhiệm pháp lý khiến mọi người thực hiện các hành động có hại khác (ví dụ: nguồn đóng, KYC và giám sát, thông đồng giữa nhà nước/doanh nghiệp để ngấm ngầm hạn chế người dùng, chẳng hạn như như ngân hàng hủy bỏ, khóa phần lớn thế giới).

Có một lập luận kinh điển chống lại việc đổ lỗi hoàn toàn cho người dùng: người dùng có thể là những người bình thường không có nhiều tiền, hoặc thậm chí là ẩn danh và không ai thực sự có thể trả giá cho tác hại thảm khốc. Lập luận này có thể bị cường điệu hóa: ngay cả khi một số người dùng quá nhỏ để phải chịu trách nhiệm, thì khách hàng trung bình của nhà phát triển AI thì không, vì vậy nhà phát triển AI vẫn sẽ được khuyến khích xây dựng thứ gì đó đảm bảo cho người dùng rằng họ sẽ không phải đối mặt sản phẩm rủi ro trách nhiệm pháp lý cao. Tuy nhiên, đây vẫn là một lập luận có căn cứ cần được giải quyết. Bạn cần khuyến khích những người trong quy trình có đủ nguồn lực để chăm sóc thích hợp và cả người triển khai và nhà phát triển đều là những mục tiêu dễ dàng vẫn có tác động lớn đến tính bảo mật của mô hình.

Trách nhiệm của người triển khai có vẻ hợp lý. Một mối lo ngại chung là nó không áp dụng cho các mô hình nguồn mở, nhưng điều này có vẻ có thể quản lý được, đặc biệt vì các mô hình mạnh nhất có thể là nguồn đóng (nếu cuối cùng chúng trở thành nguồn mở thì trách nhiệm của người triển khai cuối cùng là Không nhiều). sử dụng nhưng cũng không gây thiệt hại nhiều). Những lo ngại tương tự cũng áp dụng đối với trách nhiệm pháp lý của nhà phát triển (mặc dù với các mô hình nguồn mở, mô hình cần phải được tinh chỉnh để thực hiện những việc mà ngay từ đầu nó không được phép làm), nhưng phản bác tương tự cũng được áp dụng. Theo nguyên tắc chung, áp đặt "thuế" đối với quyền kiểm soát, về cơ bản có nghĩa là "bạn có thể xây dựng thứ mà bạn không kiểm soát hoặc bạn có thể xây dựng thứ mà bạn kiểm soát, nhưng nếu bạn xây dựng thứ mà bạn kiểm soát thì 20% quyền kiểm soát phải được sử dụng cho mục đích của chúng ta” dường như là một quan điểm hợp lý đối với hệ thống pháp luật.

Một ý tưởng dường như chưa được khám phá là đổ lỗi cho những người tham gia khác trong quy trình, những người có khả năng đảm bảo đủ nguồn lực tốt hơn. Một ý tưởng rất có lợi cho d/acc là đổ lỗi cho chủ sở hữu hoặc người điều hành bất kỳ thiết bị nào mà AI tiếp quản (ví dụ: thông qua hack) trong quá trình thực hiện một số hành động có hại nghiêm trọng. Điều này sẽ tạo ra những động lực rất lớn để mọi người làm việc chăm chỉ để làm cho cơ sở hạ tầng của thế giới (đặc biệt là máy tính và sinh học) an toàn nhất có thể.

Chiến lược thứ hai: Nút "Tạm dừng mềm" toàn cầu trên phần cứng cấp công nghiệp

Nếu tôi tin rằng chúng tôi cần thứ gì đó "mạnh mẽ" hơn các quy tắc trách nhiệm pháp lý thì đây là điều tôi sẽ theo đuổi. Mục tiêu là có thể giảm sức mạnh tính toán hiện có của thế giới khoảng 90-99% trong 1-2 năm trong giai đoạn quan trọng, giúp nhân loại có thêm thời gian chuẩn bị. Giá trị của 1-2 năm không nên quá phóng đại: nếu tự mãn, một năm “chế độ thời chiến” có thể dễ dàng có giá trị bằng cả trăm năm công sức. Các cách để thực hiện "tạm dừng" đã được khám phá, bao gồm các đề xuất cụ thể như yêu cầu đăng ký và xác minh vị trí phần cứng.

Một cách tiếp cận tiên tiến hơn sẽ là sử dụng các thủ thuật mã hóa thông minh: ví dụ: phần cứng AI cấp công nghiệp (chứ không phải cấp tiêu dùng) có thể được trang bị một chip phần cứng đáng tin cậy chỉ nhận dữ liệu từ các tổ chức quốc tế lớn hàng tuần ((bao gồm ít nhất một chi nhánh phi quân sự) cần 3/3 chữ ký để tiếp tục hoạt động. Những chữ ký này sẽ là bất khả tri của thiết bị (nếu cần, chúng tôi thậm chí có thể yêu cầu bằng chứng không có kiến thức rằng chúng đã được xuất bản trên blockchain), vì vậy sẽ là tất cả hoặc không có gì: không có cách thực tế nào để thực hiện việc này mà không cho phép tất cả các thiết bị khác để cho phép một thiết bị tiếp tục hoạt động.

Điều này giống như "đánh dấu vào ô" về mặt tối đa hóa lợi ích và giảm thiểu rủi ro:

Đây là một công cụ hữu ích khả năng: nếu chúng ta nhận được các dấu hiệu cảnh báo rằng AI gần siêu thông minh đang bắt đầu làm những việc có khả năng gây ra thiệt hại thảm khốc, chúng ta sẽ muốn thực hiện quá trình chuyển đổi chậm hơn.

Cho đến khi những thời điểm quan trọng như vậy xảy ra, việc chỉ có tính năng tạm dừng nhẹ sẽ không ảnh hưởng nhiều đến các nhà phát triển.

Tập trung vào phần cứng quy mô công nghiệp và chỉ nhắm mục tiêu 90-99% để tránh cài đặt chip gián điệp hoặc tắt công tắc trong máy tính xách tay của người tiêu dùng hoặc buộc các nước nhỏ áp dụng các phương pháp tiếp cận Dystopian như các biện pháp hà khắc.

Tập trung vào phần cứng dường như rất hiệu quả để chống lại sự thay đổi công nghệ. Chúng tôi đã thấy rằng qua nhiều thế hệ AI, chất lượng phụ thuộc rất nhiều vào sức mạnh tính toán sẵn có, đặc biệt là trong các phiên bản đầu tiên của mô hình mới. Vì vậy, việc giảm sức mạnh tính toán hiện có xuống hệ số 10-100 có thể dễ dàng xác định liệu một AI siêu thông minh ngoài tầm kiểm soát sẽ thắng hay thua trong trận chiến nhịp độ nhanh chống lại con người đang cố gắng ngăn chặn nó.

Việc phải lên mạng mỗi tuần một lần để ký đã là một điều khó chịu, điều này sẽ tạo áp lực mạnh mẽ để mở rộng chương trình sang phần cứng tiêu dùng.

Nó có thể được xác minh bằng cách kiểm tra ngẫu nhiên và việc xác minh ở cấp độ phần cứng sẽ gây khó khăn cho việc miễn trừ đối với những người dùng cụ thể (dựa trên việc buộc phải tắt máy theo luật thay vì phương pháp kỹ thuật không có thuộc tính tất cả hoặc không có gì này khiến họ có nhiều khả năng trượt theo hướng miễn trừ cho quân đội, v.v.)

Quy định về phần cứng đã được xem xét nghiêm túc, mặc dù thường thông qua khuôn khổ kiểm soát xuất khẩu mà về cơ bản là Triết lý về “ chúng tôi tin tưởng một bên của chúng tôi, nhưng không phải bên kia.” Leopold Aschenbrenner từng cho rằng Mỹ nên chạy đua để giành lợi thế quyết định rồi buộc Trung Quốc phải ký thỏa thuận hạn chế số lượng hộp mà họ được phép hoạt động. Cách tiếp cận này đối với tôi có vẻ nguy hiểm, có thể kết hợp những nhược điểm của cạnh tranh đa cực và tập trung hóa. Nếu phải hạn chế con người thì có vẻ tốt hơn là hạn chế mọi người bình đẳng và cố gắng cùng nhau tổ chức công việc, thay vì một bên cố gắng thống trị mọi người khác.

công nghệ d/acc trong AI có rủi ro

Cả hai chiến lược (nút trách nhiệm và nút tạm dừng phần cứng) đều có lỗ hổng và rõ ràng chúng chỉ là những khoảng trống tạm thời: nếu ai đó Nếu có điều gì đó có thể xảy ra được thực hiện trên siêu máy tính tại thời điểm T thì có khả năng nó sẽ được thực hiện trên máy tính xách tay trong T+5 năm. Vì vậy chúng ta cần thứ gì đó ổn định hơn để câu giờ. Nhiều kỹ thuật d/acc có liên quan đến điều này. Chúng ta có thể nhìn nhận vai trò của công nghệ d/acc theo cách này: Trí tuệ nhân tạo sẽ làm gì nếu nó chiếm lĩnh thế giới?

Nó xâm chiếm máy tính của chúng ta→ Bảo vệ mạng

Nó sẽ gây ra một siêu dịch→ Biodefense

Nó thuyết phục chúng ta (tin hoặc không tin tưởng lẫn nhau) → Bảo vệ thông tin

Như trên Như đã đề cập ngắn gọn trong bài viết quy định trách nhiệm pháp lý là d/acc đương nhiên Các phương pháp tiếp cận pháp lý thân thiện vì chúng có thể rất hiệu quả trong việc thúc đẩy thế giới áp dụng các biện pháp phòng vệ này và thực hiện chúng một cách nghiêm túc. Đài Loan gần đây đang thử nghiệm trách nhiệm pháp lý đối với những quảng cáo sai sự thật, đây có thể được coi là một ví dụ về việc sử dụng trách nhiệm pháp lý để khuyến khích bảo vệ thông tin. Chúng ta không nên quá quan tâm đến việc áp đặt trách nhiệm pháp lý ở mọi nơi và hãy nhớ lợi ích của quyền tự do thông thường là để anh chàng nhỏ bé tham gia vào quá trình đổi mới mà không sợ kiện tụng, nhưng ở những nơi chúng ta muốn thúc đẩy sự an toàn một cách mạnh mẽ hơn, trách nhiệm pháp lý có thể rất linh hoạt và hiệu quả. .

4. Vai trò của tiền điện tử trong d/acc

Phần lớn d/acc vượt xa các chủ đề blockchain điển hình: an toàn sinh học, BCI và diễn ngôn hợp tác. Các công cụ dường như khác xa với tiền điện tử. mọi người thường nói đến. Tuy nhiên, tôi nghĩ có một số mối liên hệ quan trọng giữa tiền điện tử và d/acc, cụ thể là:

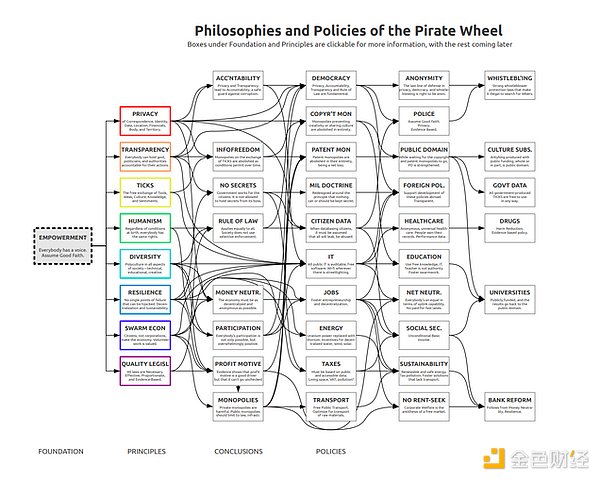

d/acc là nền tảng của tiền điện tử. các giá trị (phân cấp, chống kiểm duyệt, nền kinh tế và xã hội toàn cầu mở) cho các lĩnh vực công nghệ khác.

Vì người dùng tiền điện tử là những người chấp nhận sớm một cách tự nhiên và chia sẻ cùng các giá trị nên cộng đồng tiền điện tử là những người sử dụng sớm công nghệ d/acc một cách tự nhiên. Sự nhấn mạnh vào cộng đồng (cả trực tuyến và ngoại tuyến, chẳng hạn như sự kiện và cửa sổ bật lên) và thực tế là các cộng đồng này thực sự đang làm những việc mang tính đặt cược cao thay vì chỉ nói chuyện với nhau, khiến cộng đồng tiền điện tử trở thành một d/an đặc biệt hấp dẫn. vườn ươm và nơi thử nghiệm các công nghệ acc về cơ bản hướng tới các nhóm hơn là các cá nhân (ví dụ: phần lớn phòng thủ thông tin và phòng thủ sinh học). Những người tiền điện tử chỉ làm mọi việc cùng nhau.

Nhiều công nghệ mật mã có thể được áp dụng trong các lĩnh vực chủ đề d/acc : chuỗi khối để xây dựng cơ sở hạ tầng tài chính, quản trị và truyền thông xã hội mạnh mẽ và phi tập trung hơn, Bằng chứng không có kiến thức để bảo vệ quyền riêng tư , vân vân. Ngày nay, nhiều thị trường dự đoán lớn nhất được xây dựng trên blockchain và chúng đang dần trở nên phức tạp, phi tập trung và dân chủ hơn.

Ngoài ra còn có các cơ hội đôi bên cùng có lợi để hợp tác về các công nghệ liên quan đến tiền điện tử, rất hữu ích cho các dự án tiền điện tử nhưng cũng là chìa khóa để đạt được mục tiêu của d/acc: xác minh chính thức , bảo mật phần cứng và phần mềm máy tính cũng như các kỹ thuật quản trị đối nghịch. Những điều này làm cho chuỗi khối Ethereum, ví và DAO an toàn và mạnh mẽ hơn, đồng thời chúng cũng đạt được các mục tiêu phòng thủ văn minh quan trọng, chẳng hạn như giảm khả năng dễ bị tổn thương của chúng ta trước các cuộc tấn công mạng, bao gồm cả những cuộc tấn công có thể đến từ AI siêu thông minh.

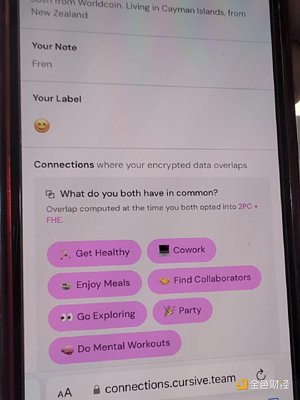

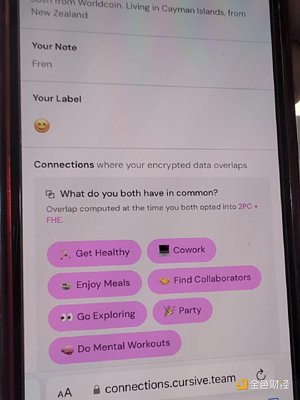

< p style="text-align: center;">Chữ thảo là một ứng dụng sử dụng mã hóa đồng hình hoàn toàn (FHE), cho phép người dùng xác định các lĩnh vực mà người dùng khác quan tâm đồng thời bảo vệ quyền riêng tư. Edge City, một trong nhiều chi nhánh của Zuzalu ở Chiang Mai, sử dụng công nghệ này. Ngoài những điểm giao nhau trực tiếp này, còn có một điểm quan trọng khác được quan tâm chung: cơ chế tài trợ.

5. d/acc và tài trợ cho hàng hóa công

Một trong những mối quan tâm hiện tại của tôi là đưa ra các cơ chế tốt hơn để tài trợ cho hàng hóa công: có giá trị đối với nhiều người nhưng không phải tự nhiên với những mô hình kinh doanh khả thi. Công việc trước đây của tôi trong lĩnh vực này bao gồm những đóng góp của tôi vào lĩnh vực tài trợ thứ cấp và ứng dụng của nó trong tài trợ Gitcoin, Retro PGF và gần đây nhất là tài trợ sâu.

Nhiều người còn hoài nghi về khái niệm hàng hóa công cộng. Sự nghi ngờ này thường xuất phát từ hai khía cạnh:

Trên thực tế, hàng hóa công trong lịch sử đã được sử dụng như một hình thức kế hoạch hóa tập trung nặng tay và chính phủ kiểm soát Một cái cớ để can thiệp vào xã hội và kinh tế.

Có một niềm tin rộng rãi rằng việc tài trợ cho hàng hóa công cộng thiếu chặt chẽ, dựa trên thành kiến mong muốn của xã hội (nghe có vẻ hay nhưng thực tế không phải như vậy) và ủng hộ việc có thể chơi trò chơi xã hội của người trong cuộc.

Đây là những lời chỉ trích quan trọng và tốt. Tuy nhiên, tôi tin rằng việc tài trợ phi tập trung mạnh mẽ cho hàng hóa công là rất quan trọng đối với tầm nhìn d/acc, vì mục tiêu chính của d/acc (giảm thiểu các điểm kiểm soát trung tâm) vốn sẽ làm nản lòng nhiều mô hình kinh doanh truyền thống. Có thể xây dựng các doanh nghiệp thành công trên nguồn mở—và nhiều người được cấp phép Balvi đang làm điều đó—nhưng trong một số trường hợp, điều đó đủ khó để các dự án quan trọng cần có sự hỗ trợ liên tục bổ sung. Vì vậy, chúng ta phải làm việc khó khăn và tìm ra cách tài trợ cho hàng hóa công theo cách giải quyết hai lời chỉ trích ở trên.

Giải pháp cho vấn đề đầu tiên về cơ bản là sự trung lập và phân cấp đáng tin cậy. Kế hoạch hóa tập trung có vấn đề vì nó nhường quyền kiểm soát cho giới tinh hoa, những người có thể lạm dụng quyền lực của họ, và nó có xu hướng quá phù hợp với hoàn cảnh hiện tại, khiến nó ngày càng kém hiệu quả theo thời gian. Tài chính thứ cấp và các cơ chế tương tự tài trợ chính xác cho hàng hóa công theo cách trung lập đáng tin cậy nhất và phi tập trung hóa (về mặt kiến trúc và chính trị) có thể.

Câu hỏi thứ hai khó khăn hơn. Một lời chỉ trích phổ biến về tài trợ bậc hai là nó có thể nhanh chóng trở thành một cuộc cạnh tranh về mức độ phổ biến, đòi hỏi các nhà tài trợ dự án phải nỗ lực đáng kể cho việc quảng bá. Ngoài ra, các dự án "trước mắt mọi người" (ví dụ: ứng dụng của người dùng cuối) sẽ nhận được tài trợ, nhưng các dự án ẩn hơn ("các dự án phụ thuộc điển hình được duy trì bởi người dân ở Nebraska") hoàn toàn không nhận được bất kỳ khoản tài trợ nào. Nguồn tài trợ ngược của Lạc quan phụ thuộc vào một số ít người nắm giữ huy hiệu chuyên gia; ở đây, tác động của các cuộc thi về mức độ nổi tiếng bị giảm bớt, nhưng tác động xã hội của việc duy trì mối quan hệ cá nhân thân thiết với những người nắm giữ huy hiệu lại được khuếch đại.

Tài trợ sâu là nỗ lực mới nhất của tôi để giải quyết vấn đề này. Tài trợ sâu có hai cải tiến chính:

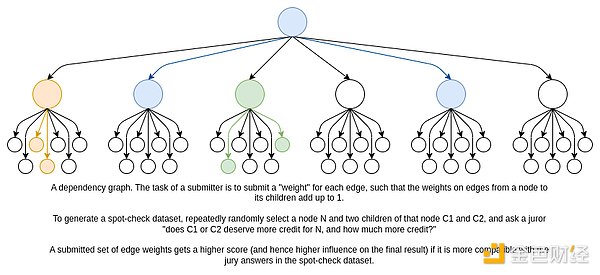

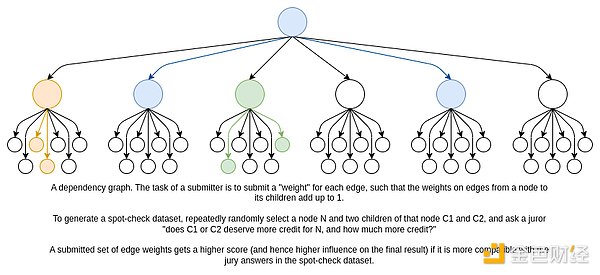

Biểu đồ phụ thuộc. Thay vì hỏi mỗi bồi thẩm đoàn một câu hỏi chung ("Giá trị của dự án A đối với nhân loại là gì?"), chúng tôi hỏi một câu hỏi địa phương ("Dự án A hay dự án B có giá trị hơn so với kết quả C? Hơn bao nhiêu?"). Con người nổi tiếng là kém trong việc trả lời các câu hỏi có tầm nhìn tổng thể: trong một nghiên cứu nổi tiếng, khi được hỏi họ sẽ chi bao nhiêu để cứu N con chim, những người được hỏi đã trả lời bằng các câu trả lời là N=2.000, N=20.000 và N=200.000 Khoảng 80 USD. Các vấn đề địa phương dễ giải quyết hơn. Sau đó, chúng tôi kết hợp các câu trả lời cục bộ thành câu trả lời toàn cầu bằng cách duy trì "biểu đồ phụ thuộc": Đối với mỗi dự án, những dự án nào khác đã đóng góp vào thành công của dự án đó và ở mức độ nào?

Trí tuệ nhân tạo là chắt lọc khả năng phán đoán của con người. Bồi thẩm đoàn sẽ chỉ được giao một mẫu nhỏ ngẫu nhiên của tất cả các câu hỏi. Có một cuộc thi mở trong đó bất kỳ ai cũng có thể gửi mô hình trí tuệ nhân tạo nhằm cố gắng lấp đầy tất cả các cạnh trong biểu đồ một cách hiệu quả. Câu trả lời cuối cùng là tổng trọng số của các mô hình phù hợp nhất với câu trả lời của ban giám khảo. Xem ví dụ về mã tại đây. Cách tiếp cận này cho phép cơ chế mở rộng quy mô rất lớn trong khi yêu cầu bồi thẩm đoàn chỉ gửi một số lượng nhỏ thông tin. Điều này làm giảm nguy cơ tham nhũng và đảm bảo mọi người đều có chất lượng cao: bồi thẩm đoàn có thể suy nghĩ lâu dài và kỹ càng về từng câu hỏi, thay vì nhấp chuột nhanh qua hàng trăm câu hỏi. Bằng cách sử dụng cạnh tranh mở cho AI, chúng tôi giảm bớt sự thiên vị trong bất kỳ quy trình quản lý và đào tạo AI nào. Thị trường mở cho trí tuệ nhân tạo là động cơ và con người là tay lái.

Nhưng tài trợ sâu chỉ là ví dụ mới nhất; trước đây đã có ý tưởng cho các cơ chế tài trợ hàng hóa công khác và sẽ còn nhiều hơn nữa trong tương lai. allo.expertphân loại chúng tốt. Mục tiêu cơ bản là tạo ra một tiện ích xã hội có thể tài trợ cho hàng hóa công với độ chính xác, công bằng và cởi mở ít nhất gần giống với cách thị trường tài trợ cho hàng hóa tư nhân. Xét cho cùng, nó không cần phải hoàn hảo; bản thân thị trường còn lâu mới hoàn hảo. Nhưng nó phải đủ hiệu quả để các nhà phát triển làm việc trong các dự án nguồn mở hàng đầu mang lại lợi ích cho mọi người có thể tiếp tục làm như vậy mà không cảm thấy cần phải thực hiện những thỏa hiệp không thể chấp nhận được.

Ngày nay, hầu hết các dự án hàng đầu trong các lĩnh vực chủ đề d/acc: vắc xin, BCI, "edge BCI" như tín hiệu điện cơ cổ tay và theo dõi mắt, thuốc chống lão hóa, phần cứng, v.v., đều được thực hiện chuyên môn một số. Điều này có những bất lợi đáng kể về mặt đảm bảo niềm tin của công chúng, như chúng ta đã thấy trong nhiều lĩnh vực nêu trên. Nó cũng chuyển sự chú ý sang động lực cạnh tranh (“Nhóm của chúng ta phải giành chiến thắng trong ngành quan trọng này!”) thay vì cuộc đua lớn hơn nhằm đảm bảo những công nghệ này phát triển đủ nhanh để bảo vệ chúng ta trong thế giới AI siêu thông minh. Vì những lý do này, nguồn tài trợ hàng hóa công mạnh mẽ có thể thúc đẩy mạnh mẽ sự cởi mở và tự do. Đây là một cách khác mà cộng đồng tiền điện tử có thể giúp d/acc: chuẩn bị cho việc áp dụng rộng rãi hơn khoa học và công nghệ nguồn mở bằng cách thực hiện những nỗ lực nghiêm túc để khám phá các cơ chế tài trợ này và làm cho chúng hoạt động tốt trong môi trường của chính họ.

6. Triển vọng tương lai

Sẽ có những thách thức đáng kể trong những thập kỷ tới. Gần đây tôi đang suy nghĩ về hai thách thức:

Sẽ có những thách thức đáng kể trong những thập kỷ tới. Gần đây tôi đang suy nghĩ về hai thách thức:

Một làn sóng công nghệ mới mạnh mẽ, đặc biệt là trí tuệ nhân tạo mạnh mẽ, đang nổi lên nhanh chóng; đây là những cạm bẫy quan trọng mà chúng ta cần tránh. “Siêu trí tuệ AI” có thể mất 5 năm hoặc có thể mất 50 năm. Dù vậy, vẫn chưa rõ liệu kết quả mặc định có nhất thiết phải tích cực hay không và như đã thảo luận trong bài này và bài trước, có một số cạm bẫy cần tránh.

Thế giới đang trở nên ít hợp tác hơn. Nhiều chủ thể quyền lực trước đây đôi khi dường như hành động theo những nguyên tắc cao quý (chủ nghĩa quốc tế, tự do, nhân loại chung... v.v.) giờ đây theo đuổi lợi ích cá nhân hoặc bộ lạc một cách cởi mở và quyết liệt hơn.

Tuy nhiên, có một điểm sáng cho những thách thức này. Đầu tiên, chúng tôi hiện có những công cụ rất mạnh mẽ để hoàn thành phần còn lại của công việc nhanh hơn:

Hiện tại và trong tương lai gần, AI có thể được sử dụng để xây dựng các công nghệ khác và có thể được sử dụng như một thành phần của quản trị (chẳng hạn như tài trợ sâu hoặc Thông tin Tài chính). Nó cũng rất phù hợp với BCI, bản thân nó có thể cải thiện năng suất hơn nữa.

Việc phối hợp trên quy mô lớn giờ đây trở nên khả thi hơn bao giờ hết. Internet và phương tiện truyền thông xã hội đã mở rộng phạm vi phối hợp, tài chính toàn cầu (bao gồm cả tiền điện tử) đã tăng cường sức mạnh, giờ đây các công cụ cộng tác và bảo vệ thông tin có thể nâng cao chất lượng của nó, và có lẽ các hình thức BCI từ người sang người sẽ sớm tăng chiều sâu của nó.

Xác minh chính thức, hộp cát (trình duyệt web, Docker, Qubes, GrapheneOS, v.v.), mô-đun phần cứng bảo mật và các mô-đun khác Công nghệ không ngừng cải tiến, cho phép an ninh mạng tốt hơn.

Viết phần mềm dưới mọi hình thức đã dễ dàng hơn nhiều so với hai năm trước.

Nghiên cứu cơ bản gần đây về cơ chế hoạt động của vi rút, đặc biệt là sự hiểu biết đơn giản rằng hình thức phòng ngừa và kiểm soát sự lây truyền vi rút quan trọng nhất là lây truyền qua không khí, đã chỉ ra cách cải thiện khả năng phòng thủ sinh học Một con đường rõ ràng hơn.

Những tiến bộ gần đây trong công nghệ sinh học (chẳng hạn như CRISPR, những tiến bộ trong hình ảnh sinh học ) đang làm cho nhiều công nghệ sinh học trở nên dễ tiếp cận hơn, cho dù là để phòng vệ, kéo dài tuổi thọ, cực kỳ hạnh phúc, khám phá nhiều điều mới lạ giả thuyết sinh học, hoặc chỉ làm điều gì đó thực sự thú vị.

Những tiến bộ trong điện toán và công nghệ sinh học đã kết hợp để tạo ra các công cụ sinh học tổng hợp mà bạn có thể sử dụng để điều chỉnh, theo dõi và cải thiện sức khỏe của mình. Các công nghệ phòng thủ mạng như mật mã giúp việc cá nhân hóa trở nên khả thi hơn.

Thứ hai, giờ đây nhiều nguyên tắc mà chúng ta yêu quý không còn được một số ít người bảo thủ nắm giữ nữa, chúng có thể được đòi lại bởi một liên minh rộng rãi chào đón bất kỳ ai trên thế giới tham gia tham gia chiếm lại. Đây có thể là lợi ích lớn nhất của việc “tái tổ chức” chính trị gần đây trên toàn thế giới và nó đáng để tận dụng. Tiền điện tử đã tận dụng tốt điều này và đạt được sức hút toàn cầu; d/acc có thể làm được điều tương tự.

Có được công cụ có nghĩa là Chúng tôi có khả năng thích ứng và cải thiện sinh học và môi trường của chúng ta, và d/acc Phần "phòng thủ" có nghĩa là chúng ta có thể làm điều này mà không xâm phạm quyền tự do của người khác. Các nguyên tắc đa nguyên tự do có nghĩa là chúng tôi có nhiều quyền hạn trong cách thực hiện sự Đa dạng này và cam kết của chúng tôi đối với các mục tiêu chung của con người có nghĩa là nó phải đạt được.

Con người chúng ta vẫn là những ngôi sao sáng nhất. Nhiệm vụ mà chúng ta phải đối mặt để xây dựng một thế kỷ 21 tươi sáng hơn, bảo vệ sự sống còn, tự do và quyền tự chủ của con người khi chúng ta hướng tới các vì sao, là một nhiệm vụ đầy thách thức. Nhưng tôi tin chúng ta có thể làm được.

Anais

Anais

< span style="font-size: 14px; căn chỉnh văn bản: center;">Devcon d/acc day

< span style="font-size: 14px; căn chỉnh văn bản: center;">Devcon d/acc day Biểu đồ lấy từ bài viết của tôi năm ngoái "

Biểu đồ lấy từ bài viết của tôi năm ngoái "

Sẽ có những thách thức đáng kể trong những thập kỷ tới. Gần đây tôi đang suy nghĩ về hai thách thức:

Sẽ có những thách thức đáng kể trong những thập kỷ tới. Gần đây tôi đang suy nghĩ về hai thách thức: