根据 Meta 周三发布的公告,Instagram 将很快开始测试模糊直接消息中的裸体。该公司写道,它将使用 "设备上的机器学习 "来检测裸体,旨在阻止以青少年为目标的色情信息勒索计划。

"裸体保护 "功能将检测直接消息中的裸体,并自动模糊它们,无论是在您收到发送给您的裸体消息时,还是在您试图向其他人发送裸体消息时。用户还将看到一条弹出消息:"分享敏感照片时请小心。由于裸体保护功能已开启,因此照片模糊不清。他人可以在你不知情的情况下截图或转发你的照片。如果您改变主意,可以取消发送照片,但其他人有可能已经看到了。"

由于处理是在设备上进行的,Meta 表示其检测仍将在 端到端加密聊天,除非用户报告,否则 Meta 无法访问图片本身。

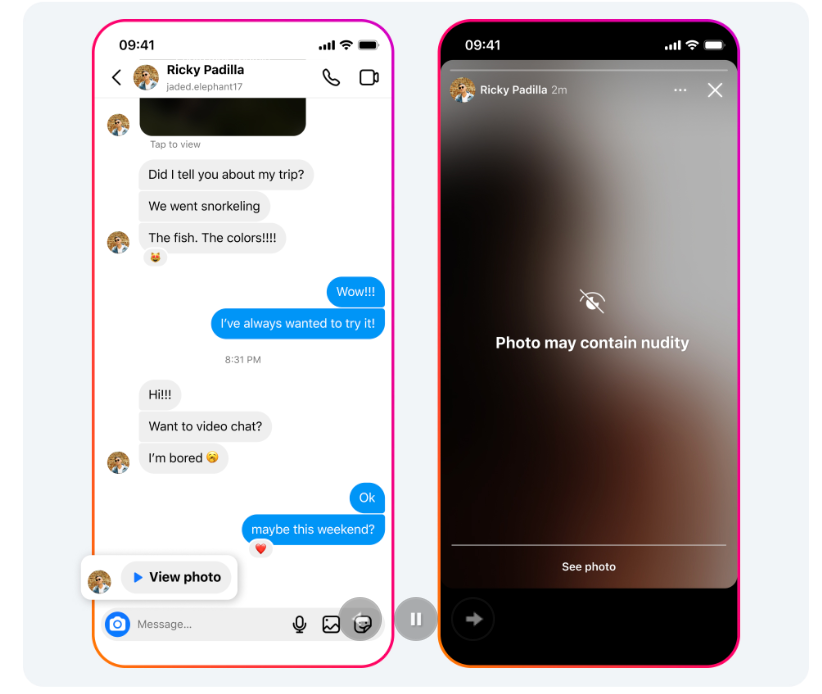

该功能在用户眼中的示例。图片来自 META

默认情况下,18 岁以下的用户将开启该功能,成年人将收到 "鼓励 "他们开启该功能的通知。"该公告称:"该功能不仅旨在保护用户不会在其 DM 中看到不受欢迎的裸体内容,而且还旨在保护用户免受骗子的欺骗,这些骗子可能会发送裸体图片来诱骗用户发送自己的图片作为回报。

"当有人收到包含裸体的图片时,该图片将在警告屏幕下自动模糊,这意味着接收者不会面对裸体图片,他们可以选择是否查看,"Meta 写道。"我们还将向他们显示一条信息,鼓励他们不要有回复的压力,并提供屏蔽发件人和报告聊天内容的选项。"

公告称 Meta 将 "很快 "开始测试这些功能。

与此同时,Meta 让 AI 生成的假冒有影响力者在 Instagram 上猖獗地盗用真实女性的图片,甚至连最明显的 catfish romance scams 在该平台上发生,而在 Facebook 上,人们不断被人工智能生成的内容所欺骗,使其相信这些内容是真实的。

Instagram 的裸体检测功能与 Apple 之前宣布的功能类似。该公司的 "敏感内容警告 "也是通过分析用户设备上的照片,根据苹果的文档。当 Apple 最初宣布推出一项更进一步的功能,即对上传到 iCloud 的照片进行 CSAM 扫描时,引起了巨大的反响。Apple 在 2022 年 12 月取消了这一计划.

美达公司过去曾在检测性虐待图像方面进行过有争议的尝试:在 2017 年和 2018 年,它测试了一个 非自愿图像预防系统,要求用户 向 Facebook 发送自己的裸体图片,以阻止它们传播。

XingChi

XingChi