Nguồn: Silicon Rabbit Race

Các tòa nhà trên thế giới có thể được chia thành hai loại. Một là khu chợ, mở cửa hàng ngày và được xây dựng từ đầu, từ nhỏ đến lớn; phần còn lại là nhà thờ, công trình này phải mất nhiều thế hệ lao động vất vả và nhiều thập kỷ mới hoàn thành. Eric Raymond đã viết như vậy trong tác phẩm The Cathedral and the Bazaar.

Câu chuyện về Linux giống như việc xây dựng một nhà thờ lớn theo kiểu chợ. Ngày nay, trong lĩnh vực trí tuệ nhân tạo tạo sinh, ngày càng có nhiều mô hình nguồn mở đóng góp những trường hợp mới cho các "mô hình xây dựng" như vậy.

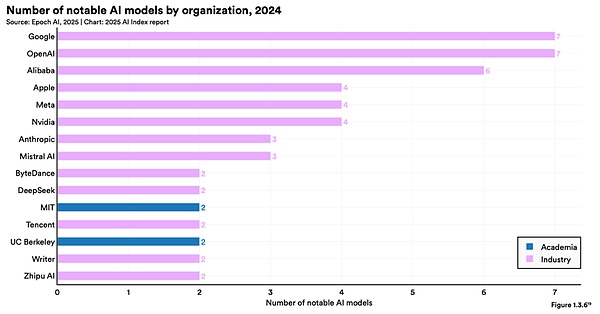

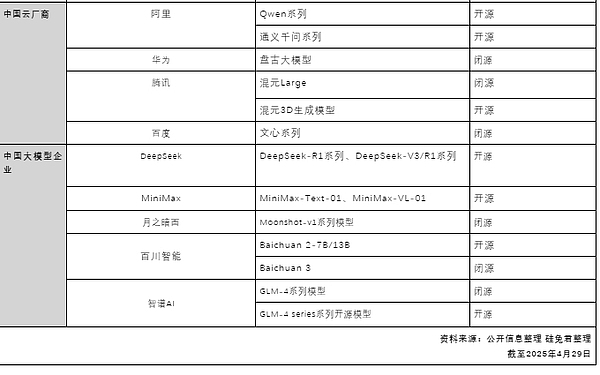

Alibaba Cloud là đơn vị theo đuổi mạnh mẽ mô hình nguồn mở. Hiện tại, số lượng mô hình phái sinh Qwen của Tongyi đã vượt quá 100.000, vượt qua mô hình Llama của Mỹ, đưa Tongyi trở thành mô hình AI nguồn mở đầu tiên trên thế giới.

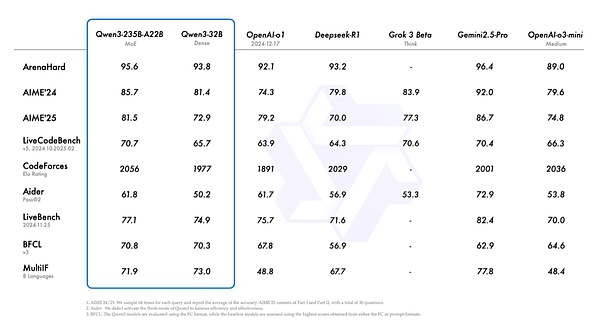

Sáng sớm ngày 29 tháng 4, Alibaba đã cho ra mắt thế hệ mới của mẫu Tongyi Qianwen Qwen3 (gọi tắt là Qianwen 3), số lượng tham số chỉ bằng một phần ba của DeepSeek-R1 là 235B và giá thành cũng đã giảm đi rất nhiều.

Người ta cho rằng Qianwen 3 là "mô hình lý luận lai" đầu tiên ở Trung Quốc. “Tư duy nhanh” và “tư duy chậm” được tích hợp vào cùng một mô hình. Đối với những nhu cầu đơn giản, nó có thể cung cấp câu trả lời trong vài giây với công suất tính toán thấp, và đối với những vấn đề phức tạp, nó có thể thực hiện "suy nghĩ sâu" theo nhiều bước, giúp tiết kiệm đáng kể mức tiêu thụ điện năng tính toán.

Từ năm 2023 đến nay, nhóm Alibaba Tongyi đã mở nguồn hơn 200 mô hình, bao gồm hai loạt mô hình cơ bản là mô hình ngôn ngữ lớn Qwen và mô hình tạo hình ảnh Wan. Mã nguồn mở này bao gồm tất cả các phương thức như mô hình tạo văn bản, mô hình hiểu/tạo trực quan, mô hình hiểu/tạo giọng nói, hình ảnh tạo văn bản và mô hình video, bao gồm mọi kích cỡ tham số từ nhỏ đến lớn để đáp ứng nhu cầu của các thiết bị đầu cuối khác nhau.

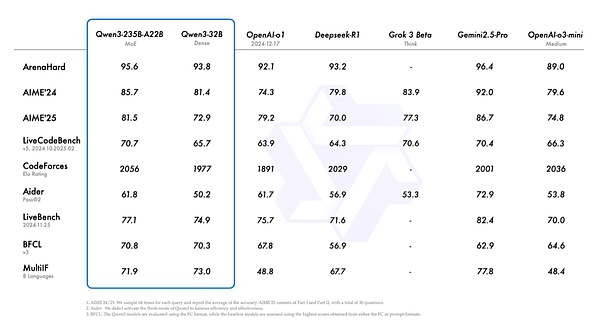

Tổng kích thước tham số của Qianwen 3 là 235B và chỉ cần 22B để kích hoạt. Lượng dữ liệu tiền đào tạo cho Qianwen 3 đạt tới 36T và nhiều vòng học tăng cường được sử dụng trong giai đoạn hậu đào tạo để tích hợp liền mạch các chế độ không suy nghĩ vào mô hình suy nghĩ.

Chi phí triển khai Qianwen 3 cũng đã giảm đáng kể. Chỉ cần 4 H20 để triển khai phiên bản đầy đủ của Qianwen 3 và mức sử dụng bộ nhớ video chỉ bằng một phần ba so với các mẫu có hiệu suất tương tự.

Việc phát hành mô hình mã nguồn mở của Alibaba có ý nghĩa gì đối với ngành công nghiệp? Mô hình nguồn mở có những khả năng gì? Cuộc thi người mẫu lớn trong tương lai sẽ đi về đâu?

01 Khả năng của các mô hình lớn nguồn mở đang bắt kịp

Khả năng của các mô hình lớn nguồn mở đang bắt kịp các mô hình nguồn đóng.

Đây là sự đồng thuận mà tác giả đạt được sau khi phỏng vấn nhiều doanh nhân AI, nhà phát triển mô hình lớn từ các công ty lớn và các nhà đầu tư.

Mặc dù họ cũng đồng ý rằng mô hình nguồn đóng vẫn đang ở vị trí dẫn đầu hiện nay, nhưng khoảng cách giữa mô hình nguồn mở và mô hình nguồn đóng đang dần thu hẹp và tốc độ này vượt quá mong đợi của ngành.

"Mô hình nguồn đóng đầu tiên đạt được số điểm 90, nhưng hiện nay, mô hình nguồn mở cũng có thể đạt được mức 90", một nhà phát triển mô hình lớn cho biết. Luật mở rộng luôn có một nút thắt. Vấn đề nan giải là mô hình càng lớn thì chi phí cải thiện khả năng sẽ tăng theo cấp số nhân, khiến các mô hình nguồn mở có thời gian để theo kịp.

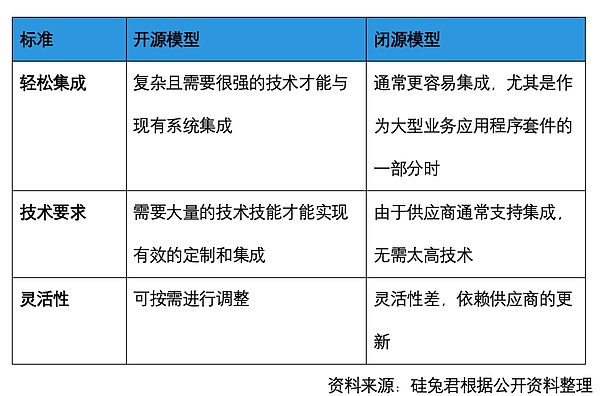

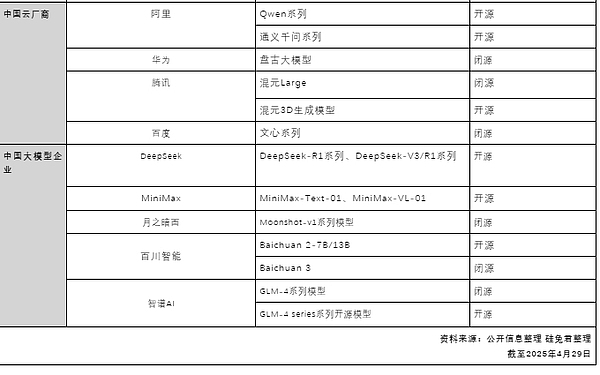

Mô hình nguồn mở thực sự mở ra điều gì? Nó khác với phần mềm nguồn mở như thế nào? Sự khác biệt so với mô hình nguồn đóng là gì?

Phần mềm nguồn mở thường công bố toàn bộ mã nguồn, cho phép các nhà phát triển xem và sửa đổi mã nguồn đó. Các nhà phát triển sau này có thể dễ dàng tái tạo các chức năng tương ứng dựa trên mã. Tuy nhiên, các mô hình nguồn mở thường chỉ cung cấp các tham số nguồn mở. Thật khó để biết dữ liệu nào được sử dụng, dữ liệu đó được tinh chỉnh như thế nào và dữ liệu đó được sắp xếp ra sao. Mô hình nguồn đóng cung cấp trực tiếp một bộ giải pháp hoàn chỉnh. Có thể hiểu rằng mô hình nguồn mở dựa trên các tài liệu có sẵn, yêu cầu đầu bếp phải tự chuẩn bị dụng cụ, thực đơn và phương pháp nghiên cứu, nhưng việc có làm ra được món ăn ngon hay không lại hoàn toàn phụ thuộc vào tay nghề của đầu bếp. Mô hình nguồn đóng là những món ăn được chế biến sẵn có thể hâm nóng và sử dụng.

Nhưng lợi thế của các mô hình nguồn mở lànó cho phép nhiều nhà phát triển tham gia vào quá trình phát triển mô hình, giúp mô hình cải thiện hiệu suất, cải thiện hệ sinh thái và có tính linh hoạt cao. Điều này có thể giúp các công ty mô hình tiết kiệm rất nhiều chi phí về nhân lực và thời gian. Đây cũng là cách tiết kiệm chi phí cho bên sử dụng mô hình mã nguồn mở.

Tuy nhiên, lợi thế về chi phí của mô hình nguồn mở vẫn đang ở giai đoạn đầu. Ví dụ, người ta tính toán rằng mô hình nguồn đóng GPT-4 có giá khoảng 10 đô la cho một triệu token đầu vào và khoảng 30 đô la cho một triệu token đầu ra, trong khi mô hình nguồn mở Llama-3-70-B có giá khoảng 60 xu cho một triệu token đầu vào và khoảng 70 xu cho một triệu token đầu ra, tức là rẻ hơn khoảng 10 lần, trong khi sự khác biệt về hiệu suất là rất nhỏ. Nhưng nếu liên quan đến việc triển khai sau đó thì đòi hỏi năng lực kỹ thuật và đầu tư cực kỳ lớn.

Tuy nhiên,Ali's mới ra mắt Qianwen 3 cũng đang dần giải quyết được vấn đề về chi phí đầu tư.Lấy Qianwen 3 mới ra mắt của Ali làm ví dụ, xét về chi phí triển khai, Qianwen 3 chỉ bằng 25% đến 35% so với phiên bản đầy đủ của R1 và chi phí triển khai mô hình đã giảm 60% đến 70%. Tổng thông số của mẫu flagship Qianwen 3 là 235B và 22B được kích hoạt, yêu cầu khoảng 4 H20 hoặc GPU có hiệu suất tương đương. Để so sánh, phiên bản đầy đủ của DeepSeek-R1 có tổng tham số là 671B và tham số kích hoạt là 37B. Mặc dù có thể chạy trên máy H20 8 card nhưng giá khá đắt (khoảng 1 triệu nhân dân tệ). Người ta thường khuyên dùng bộ bài H20 16 lá, tổng giá khoảng 2 triệu nhân dân tệ.

Theo quan điểm lý luận mô hình, mô hình lý luận lai độc đáo của Qianwen 3 cho phép các nhà phát triển thiết lập "ngân sách suy nghĩ" của riêng mình, đạt được khả năng kiểm soát suy nghĩ tinh vi hơn trong khi vẫn đáp ứng các yêu cầu về hiệu suất, điều này sẽ tự nhiên tiết kiệm chi phí lý luận tổng thể. Để tham khảo, chênh lệch giá giữa chế độ suy luận và không suy luận của cùng loại Gemini-2.5-Flash là khoảng 6 lần. Khi người dùng sử dụng chế độ không suy luận, họ có thể tiết kiệm 600% chi phí điện toán.

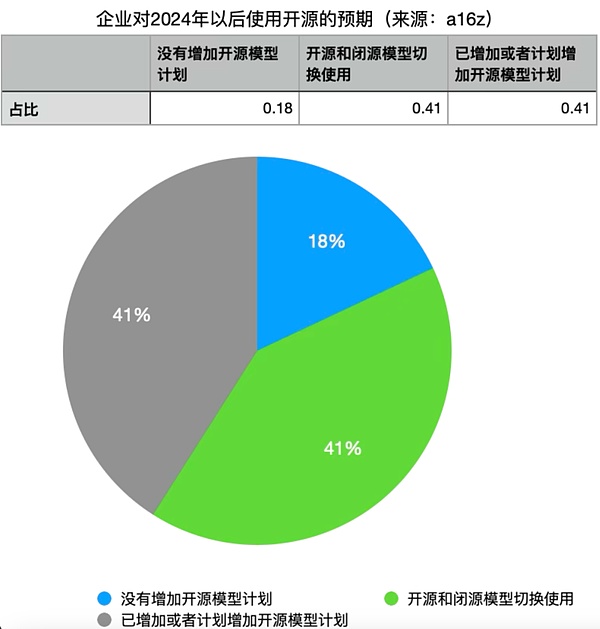

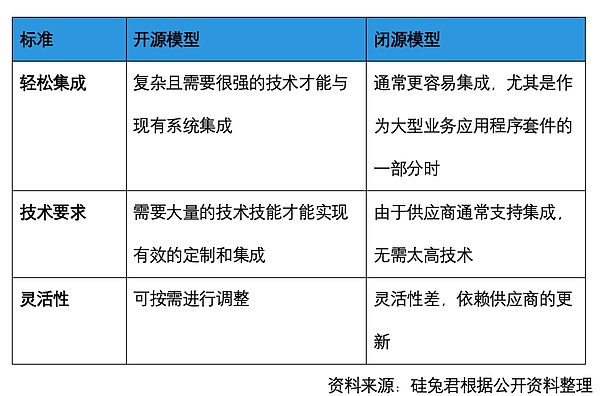

Một nhà phát triển các mô hình lớn tại một công ty lớn đã nói với Silicon Rabbit rằng các mô hình nguồn mở phù hợp hơn với các nhóm có năng lực kỹ thuật mạnh nhưng ngân sách không đủ, chẳng hạn như các tổ chức học thuật. Mô hình nguồn đóng phù hợp với các công ty có ít nhân viên và nhiều tiền. Tuy nhiên, khi khả năng của các mô hình nguồn mở được cải thiện, 41% công ty được khảo sát có kế hoạch tăng cường sử dụng các mô hình nguồn mở và 41% tin rằng nếu hiệu suất của các mô hình nguồn mở tương đương với các mô hình nguồn đóng, họ sẽ chuyển sang các mô hình nguồn mở. Trong cuộc khảo sát, chỉ có 18% doanh nghiệp không có kế hoạch tăng cường sử dụng LLM nguồn mở.

Marc Andreessen, người sáng lập A16z, cho biết nguồn mở sẽ cho phép các trường đại học quay trở lại cuộc cạnh tranh. Bởi vì các nhà nghiên cứu lo ngại rằng, thứ nhất, các trường đại học không có đủ kinh phí để cạnh tranh trong lĩnh vực AI và duy trì sự liên quan; Thứ hai, tất cả các trường đại học cộng lại không có đủ kinh phí để cạnh tranh vì không ai có thể theo kịp khả năng gây quỹ của các công ty lớn này. Khi ngày càng có nhiều mô hình nguồn mở xuất hiện và khả năng của chúng được cải thiện, điều đó có nghĩa là các trường đại học có thể sử dụng các mô hình nguồn mở cho mục đích nghiên cứu. Logic tương tự cũng áp dụng cho các công ty nhỏ không có đủ vốn.

Đồ họa của Silicon Rabbit

02 Cảm hứng phương Đông về các mô hình lớn

Sự xuất hiện của DeepSeek đã khiến nhiều người khám phá ra khả năng của các công ty Trung Quốc trong việc mở nguồn các mô hình.

"Deep Seek đại diện cho các sản phẩm AI nhẹ, chi phí thấp." Một nhà đầu tư AI từ Trung Quốc và Hoa Kỳ cho biết, ví dụ, việc điều chỉnh mô hình chuyên gia hỗn hợp (MoE) đòi hỏi trình độ tay nghề cực kỳ cao. Trước đây, không nhiều người mẫu chính thống sử dụng MoE vì nó khó, nhưng "đứa trẻ không tin vào cái ác" và đã làm.

Nhưng điều quan trọng nhất về mô hình nguồn mở là hệ sinh thái, tức là có bao nhiêu người thực sự sử dụng nó. Xét cho cùng, việc chuyển đổi giữa các mô hình khác nhau cực kỳ tốn kém cho người dùng. Tuy nhiên, khi DeepSeek ra đời, một số người dùng mô hình lớn của Meta ở Thung lũng Silicon cũng chuyển sang DeepSeek. "Những người đến sau chắc hẳn có nhiều lợi thế hơn những người đi trước." Một nhà phát triển mô hình lớn cho biết điều này sẽ thu hút người dùng từ bỏ chi phí đầu tư ban đầu và chuyển sang mô hình nguồn mở mới.

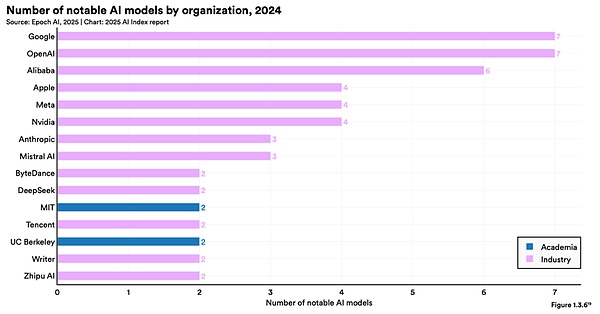

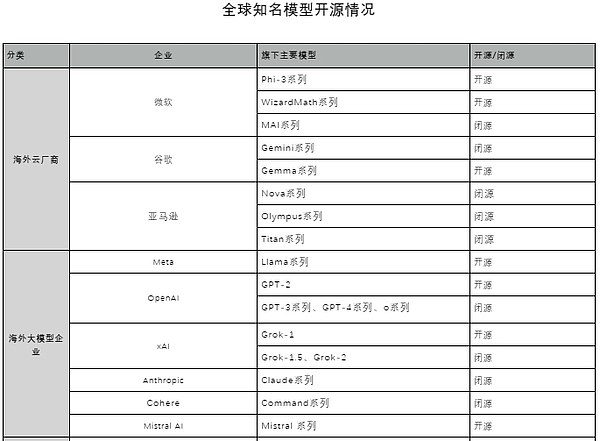

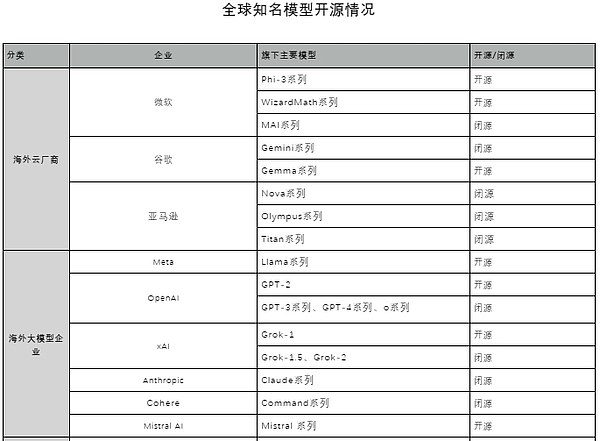

Silicon Rabbit đã phân loại các tình huống nguồn mở và nguồn đóng của các mô hình nổi tiếng thế giới và nhận thấy rằng, ngoài Amazon, Microsoft, Google, Meta và OpenAI đều có bố cục mô hình nguồn mở. Một số công ty chọn hướng đi nguồn mở thuần túy, một số khác chọn hướng đi song song là nguồn mở và nguồn đóng. Ở Trung Quốc, Alibaba là công ty lớn nhất quyết tâm theo đuổi con đường nguồn mở. Lâu trước khi DeepSeek phát hành R1, Alibaba đã đặt cược và vạch ra kế hoạch cho các mô hình nguồn mở.

Mã nguồn mở của các người mẫu nổi tiếng thế giới

Nguồn: Thông tin công khai do Silicon Rabbit biên soạn

Tính đến2025năm4tháng29ngày

|

Nguồn: Báo cáo trí tuệ nhân tạo Stanford năm 2025

1) Khả năng suy luận lai độc đáo: hỗ trợ chuyển đổi liền mạch giữa chế độ suy nghĩ (để suy luận logic phức tạp, toán học và mã hóa) và chế độ không suy nghĩ (để trò chuyện chung hiệu quả), đảm bảo hiệu suất tối ưu trong nhiều tình huống khác nhau.

2) Khả năng suy luận được cải thiện đáng kể: vượt trội hơn mô hình hướng dẫn QwQ (ở chế độ suy nghĩ) và Qwen2.5-Instruct (ở chế độ không suy nghĩ) trước đây về toán học, tạo mã và suy luận logic thông thường.

3) Phù hợp hơn với sở thích của con người: xuất sắc trong khả năng viết sáng tạo, nhập vai, trò chuyện nhiều chiều và tuân theo mệnh lệnh, mang đến trải nghiệm trò chuyện tự nhiên, hấp dẫn và đắm chìm hơn.

4) Khả năng tác nhân vượt trội: Có thể tích hợp chính xác các công cụ bên ngoài ở chế độ suy nghĩ và không suy nghĩ, và thực hiện hàng đầu trong số các mô hình nguồn mở trong các tác vụ phức tạp dựa trên tác nhân.

5) Khả năng đa ngôn ngữ mạnh mẽ: Hỗ trợ 119 ngôn ngữ và phương ngữ, có khả năng theo dõi lệnh đa ngôn ngữ và khả năng dịch thuật mạnh mẽ.

“Lý luận lai” được đề cập ở đây tương đương với việc tích hợp mô hình lý luận hàng đầu và mô hình phi lý luận vào cùng một mô hình, đòi hỏi thiết kế và đào tạo cực kỳ tinh vi và sáng tạo. Hiện nay, trong số các mẫu máy phổ biến, chỉ có Qianwen 3, Claude3.7 và Gemini 2.5 Flash có thể làm được điều này.

Cụ thể, ở "chế độ lý luận", mô hình sẽ thực hiện nhiều bước trung gian hơn, chẳng hạn như phân tích vấn đề, suy luận từng bước, xác minh câu trả lời, v.v., để đưa ra câu trả lời chu đáo hơn; trong khi ở "chế độ không lý luận", mô hình sẽ trực tiếp tạo ra câu trả lời. Cùng một mô hình có thể thực hiện cả “suy nghĩ nhanh” và “suy nghĩ chậm”, tương tự như cách con người trả lời các câu hỏi đơn giản một cách nhanh chóng dựa trên kinh nghiệm hoặc trực giác, sau đó suy nghĩ cẩn thận và đưa ra câu trả lời khi đối mặt với những câu hỏi phức tạp và khó. Qianwen 3 cũng cho phép API thiết lập “ngân sách suy nghĩ” (tức là số lượng mã thông báo suy nghĩ tối đa dự kiến) để thực hiện các cấp độ suy nghĩ khác nhau, cho phép mô hình đạt được sự cân bằng tốt hơn giữa hiệu suất và chi phí để đáp ứng nhu cầu đa dạng của các nhà phát triển và tổ chức.

Hiệu suất của Qwen3

Đối với Trung Quốc, mô hình nguồn mở cũng có thể thu hút nhiều khách hàng hơn mô hình nguồn đóng, vì nếu là mô hình nguồn đóng, nó chỉ có thể tập trung nhiều hơn ở thị trường trong nước, nhưng nguồn mở có thể cho phép nhiều công ty nước ngoài sử dụng hơn. Ví dụ: Perplexitylà một công ty của Mỹ, nhưng người dùng có thể DeepSeek R1 được sử dụng trên Perplexity và được lưu trữ hoàn toàn tại Hoa Kỳ, sử dụng các trung tâm dữ liệu của Hoa Kỳ.

03 BigNửa sau của mô hình

Vào tháng 3 năm 2023, tại một sự kiện AI nguồn mở tại Exploratorium ở San Francisco, những chú alpaca đi dạo quanh địa điểm này và tỏ lòng tôn kính với mô hình ngôn ngữ lớn nguồn mở "LLaMA" của Meta.

Trong hơn một năm kể từ năm 2023, AI tạo sinh đã liên tục thay đổi. Sự chú ý của công chúng đã chuyển từ các mô hình cơ bản sang các ứng dụng AI gốc. Trong Ngày trình diễn của YC W25, 80% các dự án là ứng dụng AI.

“Mô hình nguồn mở sẽ thúc đẩy việc triển khai nhiều tác nhân hơn.”Nhiều người trong ngành đã bày tỏ quan điểm này với Silicon Rabbit. Một mặt, mã nguồn mở sẽ giảm chi phí và ngưỡng sử dụng.

Ví dụ, Qianwen 3 có khả năng gọi công cụ mạnh mẽ. Trong danh sách đánh giá BFCL của lệnh gọi hàm Berkeley, Qianwen 3 đã thiết lập mức cao mới là 70,76, điều này sẽ làm giảm đáng kể ngưỡng để Agent gọi các công cụ. Đồng thời, khuôn khổ mã nguồn mở Qwen-Agent có thể được kết hợp để hiện thực hóa đầy đủ các khả năng của tác nhân thông minh Qwen3. Qwen-Agent là một khuôn khổ để phát triển các ứng dụng LLM dựa trên chức năng theo dõi hướng dẫn, sử dụng công cụ, lập kế hoạch và bộ nhớ của Qwen. Khung này bao gồm các mẫu lệnh gọi công cụ và trình phân tích lệnh gọi công cụ, đồng thời đi kèm với các ứng dụng mẫu như trợ lý trình duyệt, trình thông dịch mã và trợ lý tùy chỉnh, giúp giảm đáng kể độ phức tạp của mã hóa. Qianwen 3 hỗ trợ giao thức MCP. Các nhà phát triển cần xác định các công cụ có sẵn. Dựa trên tệp cấu hình MCP, họ có thể sử dụng các công cụ tích hợp của Qwen-Agent hoặc tích hợp các công cụ khác để nhanh chóng phát triển một tác nhân thông minh với các cài đặt, cơ sở kiến thức RAG và khả năng sử dụng công cụ.

Không chỉ vậy,Qianwen 3 của Ali có thể hỗ trợ các mô hình có nhiều kích cỡ khác nhau.Qianwen 3 thân thiện hơn với việc triển khai các thiết bị và tình huống thông minh như điện thoại di động, kính thông minh, lái xe thông minh và rô bốt hình người. Tất cả các công ty đều có thể tải xuống và sử dụng miễn phí các mô hình dòng Qianwen 3 cho mục đích thương mại, điều này sẽ thúc đẩy đáng kể việc ứng dụng các mô hình AI lớn trên các thiết bị đầu cuối.

Ngoài ra, một số học viên chỉ ra rằng các mô hình nguồn đóng không giải quyết tốt vấn đề tin cậy ở phía To B. Trên thực tế, nhiều công ty lớn không muốn kết nối doanh nghiệp của họ với API của các mô hình lớn của bên thứ ba, vì câu hỏi đặt ra là liệu dữ liệu cốt lõi có trở thành một phần trong quá trình đào tạo mô hình lớn của bên thứ ba hay không. Đây cũng là cơ hội cho các mô hình nguồn mở.

Có câu nói rằng mã nguồn mở là một chiến lược tiếp thị cho các sản phẩm đầu tiên trước khi chúng trải qua giai đoạn thử nghiệm beta. Khi chúng ta không biết ngày mai sẽ thế nào, chúng ta sẽ mở mã nguồn trước để thu hút các nhà phát triển. Khi ai đó bắt đầu sử dụng nó, các phương pháp hay nhất sẽ xuất hiện và sau đó hệ sinh thái riêng của họ sẽ được thiết lập.

Tuy nhiên, vì chuỗi kinh doanh của mô hình nguồn mở dài hơn và không nhanh và rõ ràng như mô hình nguồn đóng, nên những người trong ngành cho rằngmô hình nguồn mở phù hợp hơn với các trò chơi của "thế hệ thứ hai giàu có" có gia đình có tiền và nguồn lực.Lấy Meta làm ví dụ, mô hình nguồn mở của Meta tập trung nhiều hơn vào việc xây dựng hệ sinh thái và cung cấp hỗ trợ cho các phân khúc kinh doanh khác của Meta. Lý do Alibaba sử dụng mã nguồn mở chủ yếu là để phục vụ cho các dịch vụ đám mây của mình. Alibaba có các dịch vụ cơ sở hạ tầng đám mây mạnh mẽ, có thể đào tạo các mô hình lớn. Các mô hình lớn cũng có thể được triển khai trên các nhà cung cấp dịch vụ đám mây riêng và thậm chí các mô hình lớn tùy chỉnh cũng có thể được triển khai theo nhu cầu của người dùng, do đó thực hiện được logic kinh doanh.

"Mô hình của tôi là để các công ty lớn, công ty nhỏ và nguồn mở cạnh tranh với nhau. Đây chính là những gì đã xảy ra trong ngành công nghiệp máy tính." Mark Andreessen đã từng nói. Khi các mô hình lớn dần trở thành sản phẩm tiêu chuẩn như nước, điện và than, nguồn mở có thể là hướng đi phù hợp hơn cho tương lai.

Joy

Joy