Tác giả: Wuyue, Geek web3

Khi công nghệ chuỗi khối lặp đi lặp lại ngày càng nhanh hơn, tối ưu hóa hiệu suất đã trở thành một vấn đề then chốt và lộ trình Ethereum Rollup rất rõ ràng và giao dịch nối tiếp. đặc tính xử lý của EVM là một hạn chế và không thể đáp ứng các kịch bản tính toán đồng thời cao trong tương lai.

Trong bài viết trước——"Nhìn vào Con đường Tối ưu hóa EVM song song từ Reddio", chúng tôi đã đưa ra một cái nhìn tổng quan ngắn gọn về các ý tưởng thiết kế EVM song song của Reddio và hôm nay Trong Trong bài viết này, chúng tôi sẽ giải thích sâu hơn về giải pháp kỹ thuật và sự kết hợp của nó với AI.

Vì giải pháp kỹ thuật của Reddio sử dụng CuEVM nên đây là dự án sử dụng GPU để cải thiện hiệu quả thực thi EVM. Trước tiên, chúng tôi sẽ bắt đầu với CuEVM.

Tổng quan về CUDA

CuEVM là một dự án sử dụng GPU để tăng tốc EVM. Nó chuyển đổi các opcode của Ethereum EVM thành Hạt nhân CUDA để chạy trên thực thi song song. GPU NVIDIA. Cải thiện hiệu quả thực thi các lệnh EVM thông qua khả năng tính toán song song của GPU. Người dùng thẻ N có thể thường xuyên nghe thấy từ CUDA - Kiến trúc thiết bị hợp nhất điện toán, thực chất là một nền tảng điện toán và mô hình lập trình song song được phát triển bởi NVIDIA. Nó cho phép các nhà phát triển tận dụng khả năng tính toán song song của GPU cho tính toán chung (chẳng hạn như khai thác tiền điện tử, hoạt động ZK, v.v.),không chỉ xử lý đồ họa.

Là một khung tính toán song song mở, CUDA về cơ bản là một phần mở rộng của ngôn ngữ C/C++. Bất kỳ lập trình viên cấp thấp nào quen với C/C++ đều có thể bắt đầu nhanh chóng. Một khái niệm rất quan trọng trong CUDA là Kernel (hàm kernel), cũng là một hàm C++.

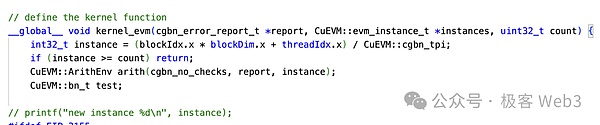

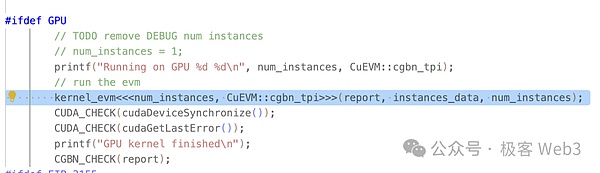

Nhưng không giống như các hàm C++ thông thường chỉ được thực thi một lần, các hàm kernel này được khởi động sau Cú pháp <<<...>>> sẽ được thực thi song song N lần bởi N luồng CUDA khác nhau khi được gọi.

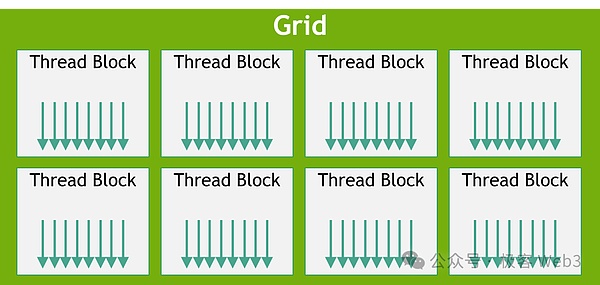

Mỗi luồng trong CUDA được gán một ID luồng độc lập và sử dụng Phân cấp luồng để phân bổ các luồng thành các khối và lưới để tạo thuận lợi cho việc quản lý một số lượng lớn các luồng song song. Thông qua trình biên dịch nvcc của NVIDIA, chúng ta có thể biên dịch mã CUDA thành một chương trình có thể chạy trên GPU.

Quy trình làm việc cơ bản của CuEVM

< p>Sau khi hiểu một loạt khái niệm cơ bản về CUDA, bạn có thể xem quy trình làm việc của CuEVM.

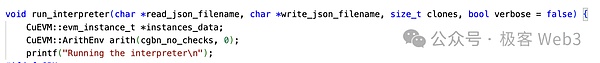

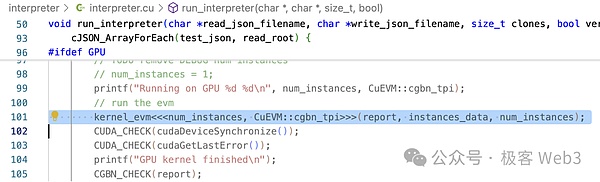

Cổng vào chính của CuEVM là run_interpreter. Từ đây, các giao dịch được xử lý song song sẽ được nhập vào dưới dạng tệp json. Từ các trường hợp sử dụng của dự án, có thể thấy rằng đầu vào đều là nội dung EVM tiêu chuẩn và nhà phát triển không cần phải xử lý, dịch, v.v. một cách riêng biệt.

Như bạn có thể thấy trong run_interpreter(), nó sử dụng thẻ do CUDA xác định< <...>> cú pháp gọi hàm kernel kernel_evm(). Như chúng tôi đã đề cập ở trên, các hàm kernel được gọi song song trên GPU.

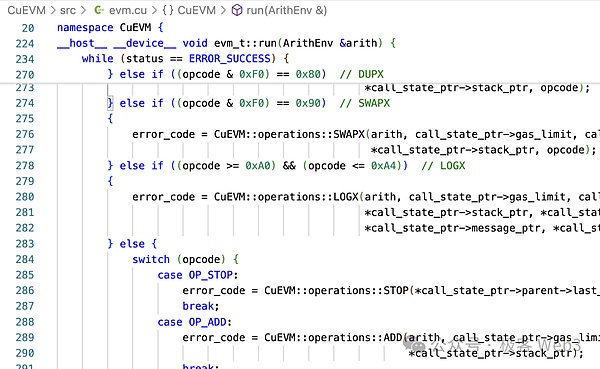

evm->run() sẽ được gọi trong phương thức kernel_evm() , chúng ta có thể thấy rằng có một số lượng lớn các phán đoán nhánh để chuyển đổi các mã EVM thành các hoạt động CUDA.

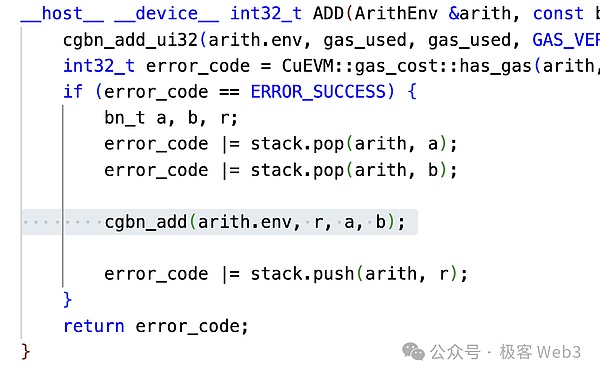

Lấy mã phép toán cộng OP_ADD trong EVM làm ví dụ, bạn có thể thấy mà nó sẽ THÊM được chuyển đổi thành cgbn_add. CGBN (Các nhóm hợp tác số lớn) là thư viện phép toán số nguyên đa chính xác hiệu suất cao của CUDA.

Hai bước này chuyển đổi mã hoạt động EVM thành hoạt động CUDA. Có thể nói CuEVM cũng là nơi thực hiện toàn bộ hoạt động EVM trên CUDA. Cuối cùng, phương thức run_interpreter() trả về kết quả hoạt động, đó là trạng thái thế giới và các thông tin khác.

Tại thời điểm này, logic vận hành cơ bản của CuEVM đã được giới thiệu.

CuEVM có khả năng xử lý các giao dịch song song, nhưng mục đích của dự án CuEVM (hoặc trường hợp sử dụng chính được hiển thị) là thực hiện kiểm tra Fuzzing: Fuzzing là một loại tự động hóa Công nghệ kiểm thử phần mềm xác định các lỗi tiềm ẩn và các vấn đề bảo mật bằng cách nhập một lượng lớn dữ liệu không hợp lệ, không mong muốn hoặc ngẫu nhiên vào chương trình để quan sát phản hồi của chương trình.

Chúng ta có thể thấy Fuzzing rất phù hợp cho việc xử lý song song. CuEVM không giải quyết các vấn đề như xung đột giao dịch, đó không phải là mối quan tâm của nó. Nếu muốn tích hợp CuEVM, bạn cũng cần xử lý các giao dịch xung đột.

Bài viết trước của chúng tôi"Xem xét Tối ưu hóa EVM song song từ Reddio" Cơ chế xử lý xung đột được Reddio sử dụng đã được giới thiệu trong bài viết và sẽ không nhắc lại ở đây. Sau khi Reddio sắp xếp các giao dịch bằng cơ chế xử lý xung đột, nó có thể được gửi đến CuEVM. Nói cách khác, cơ chế sắp xếp giao dịch của Reddio L2 có thể được chia thành hai phần: xử lý xung đột + thực thi song song CuEVM.

Layer2, EVM song song, giao điểm ba chiều của AI

Như đã đề cập ở trên, EVM song song và L2 chỉ là điểm khởi đầu của Reddio, và lộ trình tương lai của nó Kết hợp cách kể chuyện rõ ràng và AI. Reddio, sử dụng GPU cho các giao dịch song song tốc độ cao, đương nhiên phù hợp với điện toán AI với nhiều tính năng:

- < p>GPU có khả năng xử lý song song mạnh mẽ và phù hợp để thực hiện các phép toán tích chập trong học sâu. Các phép toán này về cơ bản là phép nhân ma trận quy mô lớn và GPU được tối ưu hóa cho các tác vụ như vậy.

Cấu trúc phân cấp luồng của GPU có thể phù hợp với mối quan hệ tương ứng của các cấu trúc dữ liệu khác nhau trong điện toán AI, điều này có thể được cải thiện thông qua việc cung cấp quá mức luồng và Đơn vị thực thi Warp. Tính toán hiệu quả và che giấu độ trễ bộ nhớ.

Cường độ tính toán là chỉ số quan trọng để đo lường hiệu suất tính toán AI. GPU cải thiện khả năng nhân ma trận trong điện toán AI bằng cách tối ưu hóa cường độ tính toán, chẳng hạn như giới thiệu Tensor Core. ., đạt được sự cân bằng hiệu quả giữa tính toán và truyền dữ liệu.

Vậy làm cách nào để kết hợp AI và L2?

Chúng tôi biết rằng trong thiết kế kiến trúc của Rollup, toàn bộ mạng không chỉ là trình sắp xếp thứ tự mà còn có các vai trò như người giám sát và người chuyển tiếp để xác minh hoặc thu thập các giao dịch. cùng một máy khách với bộ sắp xếp, nhưng chúng thực hiện các chức năng khác nhau. Trong Rollup truyền thống, chức năng và quyền của các vai trò phụ này rất hạn chế. Ví dụ: vai trò người theo dõi trong Arbitrum về cơ bản là thụ động, phòng thủ và phúc lợi công cộng, đồng thời mô hình lợi nhuận của nó cũng còn nhiều nghi vấn.

Reddio sẽ áp dụng kiến trúc phân loại phi tập trung và các thợ đào sẽ cung cấp GPU dưới dạng nút. Toàn bộ mạng Reddio có thể phát triển từ L2 thuần túy thành mạng L2+AI toàn diện, có thể triển khai tốt một số trường hợp sử dụng chuỗi khối AI+:

AI Agent Interactive cơ bản network

Với sự phát triển không ngừng của công nghệ blockchain, tiềm năng ứng dụng của AI Agent trong mạng blockchain là rất lớn. Hãy lấy Đại lý AI thực hiện các giao dịch tài chính làm ví dụ. Các đại lý thông minh này có thể tự động đưa ra các quyết định phức tạp và thực hiện các hoạt động giao dịch, thậm chí có thể phản hồi nhanh chóng trong điều kiện tần suất cao. Tuy nhiên, về cơ bản, L1 không thể chịu tải giao dịch lớn khi xử lý các hoạt động chuyên sâu như vậy.

Là một dự án L2, Reddio có thể cải thiện đáng kể khả năng xử lý giao dịch song song thông qua GPU tăng tốc. So với L1, L2, hỗ trợ thực hiện các giao dịch song song, có thông lượng cao hơn và có thể xử lý hiệu quả các yêu cầu giao dịch tần suất cao từ một số lượng lớn Đại lý AI để đảm bảo mạng vận hành trơn tru.

Trong giao dịch tần suất cao, Đại lý AI có yêu cầu cực kỳ nghiêm ngặt về tốc độ giao dịch và thời gian phản hồi. L2 giảm thời gian xác minh và thực hiện giao dịch, từ đó giảm đáng kể độ trễ. Điều này rất quan trọng đối với các tác nhân AI cần phản hồi ở cấp độ mili giây. Bằng cách di chuyển một số lượng lớn giao dịch sang L2, vấn đề tắc nghẽn của mạng chính cũng được giảm bớt một cách hiệu quả. Làm cho hoạt động của Đại lý AI hiệu quả hơn về mặt chi phí.

Khi các dự án L2 như Reddio trưởng thành, AI Agent sẽ đóng vai trò quan trọng hơn trong blockchain, thúc đẩy sự đổi mới của DeFi và các kịch bản ứng dụng blockchain khác kết hợp với AI.

Thị trường năng lượng tính toán phi tập trung

Reddio sẽ áp dụng kiến trúc phân loại phi tập trung trong tương lai. Các thợ mỏ sẽ sử dụng sức mạnh tính toán GPU để xác định quyền phân loại. GPU của những người tham gia mạng sẽ dần dần được cải thiện khi cạnh tranh và thậm chí có thể đạt đến cấp độ được sử dụng để đào tạo AI.

Xây dựng thị trường sức mạnh tính toán GPU phi tập trung để cung cấp tài nguyên sức mạnh tính toán với chi phí thấp hơn cho việc đào tạo và suy luận AI. Từ sức mạnh tính toán nhỏ đến lớn, từ máy tính cá nhân đến cụm phòng máy tính, mọi cấp độ sức mạnh tính toán GPU đều có thể tham gia thị trường để đóng góp sức mạnh tính toán nhàn rỗi của mình và kiếm thu nhập. Mô hình này có thể giảm chi phí tính toán AI và cho phép nhiều người tham gia hơn. phát triển và ứng dụng mô hình.

Trong trường hợp sử dụng thị trường sức mạnh tính toán phi tập trung, trình sắp xếp chuỗi có thể không chịu trách nhiệm chính trong việc tính toán trực tiếp AI. Chức năng chính của nó là xử lý các giao dịch và điều phối sức mạnh tính toán AI trong toàn bộ mạng. Về sức mạnh tính toán và phân bổ nhiệm vụ, có hai chế độ:

Tự động lên trên- giảm phân phối tập trung. Nhờ bộ sắp xếp, bộ sắp xếp có thể phân bổ các yêu cầu sức mạnh tính toán nhận được cho các nút đáp ứng yêu cầu và có danh tiếng tốt. Mặc dù phương pháp phân bổ này có vấn đề về tập trung và không công bằng về mặt lý thuyết, nhưng trên thực tế, những ưu điểm về hiệu quả mà nó mang lại vượt xa những nhược điểm của nó và về lâu dài, bộ phân loại phải đáp ứng tổng dương của toàn bộ mạng để phát triển lâu dài. , nghĩa là có các ràng buộc ngầm nhưng trực tiếp đảm bảo rằng bộ sắp xếp không quá sai lệch.

Lựa chọn nhiệm vụ tự phát từ dưới lên. Người dùng cũng có thể gửi yêu cầu tính toán AI tới các nút của bên thứ ba. Trong các trường ứng dụng AI cụ thể, điều này rõ ràng hiệu quả hơn việc gửi chúng trực tiếp đến trình sắp xếp chuỗi và cũng có thể ngăn chặn sự kiểm duyệt và sai lệch của trình sắp xếp chuỗi. Sau khi thao tác hoàn tất, nút sẽ đồng bộ hóa kết quả thao tác với trình sắp xếp thứ tự và tải chúng lên chuỗi.

Chúng ta có thể thấy rằng trong kiến trúc L2 + AI, thị trường sức mạnh tính toán có tính linh hoạt cực cao và có thể tập trung theo hai hướng. năng lượng, tối đa hóa việc sử dụng tài nguyên.

Lý luận AI trên chuỗi

Hiện tại, mô hình nguồn mở đã đủ trưởng thành để đáp ứng các nhu cầu đa dạng. Với việc tiêu chuẩn hóa các dịch vụ suy luận AI, có thểkhám phá cách đưa sức mạnh tính toán vào chuỗi để đạt được mức giá tự động. Tuy nhiên, điều này đòi hỏi phải vượt qua một số thách thức kỹ thuật:

Hiệu quả phân phối và ghi lại yêu cầu:Suy luận mô hình lớn có yêu cầu về độ trễ cao và cơ chế phân phối yêu cầu hiệu quả là rất quan trọng. Mặc dù dữ liệu yêu cầu và phản hồi rất lớn và riêng tư và không được công khai trên blockchain, nhưng phải tìm thấy sự cân bằng giữa ghi và xác minh - ví dụ: bằng cách lưu trữ hàm băm.

Xác minh đầu ra của nút nguồn điện toán: Nút đó có thực sự hoàn thành các nhiệm vụ điện toán được chỉ định không? Ví dụ: báo cáo sai nút sử dụng kết quả tính toán mô hình nhỏ thay vì mô hình lớn.

Lý luận hợp đồng thông minh: Việc kết hợp mô hình AI với hợp đồng thông minh để tính toán là cần thiết trong nhiều tình huống. Vì lý luận AI không chắc chắn và không thể được sử dụng trong tất cả các khía cạnh trên chuỗi, nên logic của các ứng dụng AI trong tương lai có thể sẽ nằm một phần ngoài chuỗi và phần còn lại nằm trong các hợp đồng trên chuỗi có giá trị. đầu vào được cung cấp ngoài chuỗi bị giới hạn bởi tính chất và tính pháp lý về số lượng. Trong hệ sinh thái Ethereum, khi kết hợp với các hợp đồng thông minh, bạn phải đối mặt với tính tuần tự kém hiệu quả của EVM.

Nhưng trong kiến trúc của Reddio, những vấn đề này tương đối dễ giải quyết:

Việc phân phối yêu cầu của trình sắp xếp hiệu quả hơn nhiều so với L1 và có thể được coi là ngang bằng với hiệu quả của Web2. Đối với vị trí ghi và phương pháp lưu giữ dữ liệu, nó có thể được giải quyết bằng nhiều giải pháp DA giá rẻ khác nhau.

Kết quả của hoạt động AI cuối cùng có thể được ZKP xác minh để xác minh tính chính xác và thiện chí của chúng. Đặc điểm của ZKP là xác minh rất nhanh nhưng tạo ra bằng chứng lại chậm. Việc tạo ZKP cũng có thể được tăng tốc bằng GPU hoặc TEE.

Solidty → CUDA → GPU, dòng chính song song EVM, là nền tảng của Reddio. Vì vậy, nhìn bề ngoài thì đây có vẻ là vấn đề dễ dàng nhất đối với Reddio. Reddio hiện đang hợp tác với Eliza của AiI6z để giới thiệu các mô-đun của mình vào Reddio. Đây là một hướng đi đáng để khám phá.

Tóm tắt

Nhìn chung, các lĩnh vực giải pháp Layer2, EVM song song và công nghệ AI dường như không liên quan đến nhau. , nhưng Reddio đã khéo léo kết hợp các lĩnh vực đổi mới chính này bằng cách tận dụng tối đa các đặc tính tính toán của GPU.

Bằng cách sử dụng các đặc tính tính toán song song của GPU, Reddio cải thiện tốc độ và hiệu quả giao dịch trên Lớp 2, từ đó nâng cao hiệu suất của lớp thứ hai của Ethereum. Tích hợp công nghệ AI vào blockchain là một nỗ lực mới lạ và đầy hứa hẹn. Việc giới thiệu AI có thể cung cấp khả năng phân tích thông minh và hỗ trợ ra quyết định cho các hoạt động trên chuỗi, từ đó đạt được các ứng dụng blockchain thông minh và năng động hơn. Sự tích hợp đa lĩnh vực này chắc chắn đã mở ra những con đường và cơ hội mới cho sự phát triển của toàn ngành.

Tuy nhiên, cần lưu ý rằng lĩnh vực này vẫn còn ở giai đoạn đầu và cần nhiều nghiên cứu, thăm dò. Sự lặp lại và tối ưu hóa công nghệ liên tục, cũng như trí tưởng tượng và hành động của những người tiên phong trên thị trường, sẽ là động lực chính giúp sự đổi mới này trưởng thành. Reddio đã có một bước đi quan trọng và táo bạo tại ngã tư này, và chúng tôi mong muốn được thấy nhiều đột phá và bất ngờ hơn nữa trong lĩnh vực hội nhập này trong tương lai.

JinseFinance

JinseFinance

JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance