Tác giả: Frank Fu @IOSG

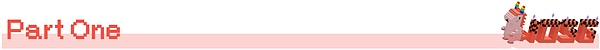

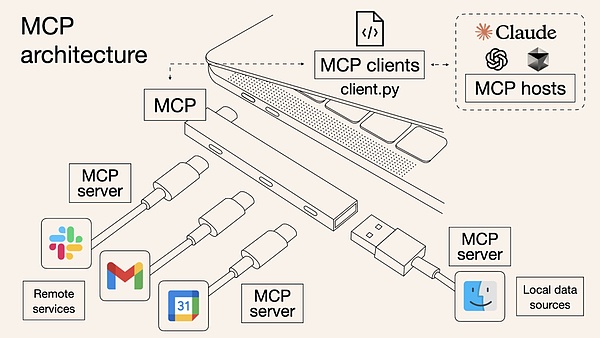

MCP đang nhanh chóng chiếm giữ vị trí cốt lõi trong hệ sinh thái Web3 AI Agent. Nó giới thiệu MCP Server thông qua kiến trúc giống như plug-in, cung cấp cho AI Agent các công cụ và khả năng mới.

Tương tự như các câu chuyện mới nổi khác trong không gian AI Web3 (như mã hóa rung cảm), MCP hay Giao thức bối cảnh mô hình có nguồn gốc từ AI Web2 và hiện đang được tái hiện trong bối cảnh Web3.

MCP là gì?

MCP là một giao thức mở do Anthropic đề xuất để chuẩn hóa cách các ứng dụng truyền thông tin theo ngữ cảnh tới các mô hình ngôn ngữ lớn (LLM). Điều này cho phép sự cộng tác liền mạch hơn giữa các công cụ, dữ liệu và tác nhân AI.

Tại sao điều này lại quan trọng?

Những hạn chế cốt lõi mà các mô hình ngôn ngữ lớn hiện tại phải đối mặt bao gồm:

Không thể duyệt Internet theo thời gian thực

Không thể truy cập trực tiếp vào các tệp cục bộ hoặc riêng tư

Không thể tự động tương tác với phần mềm bên ngoài

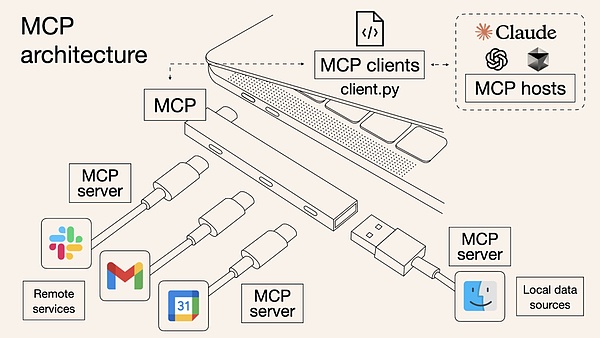

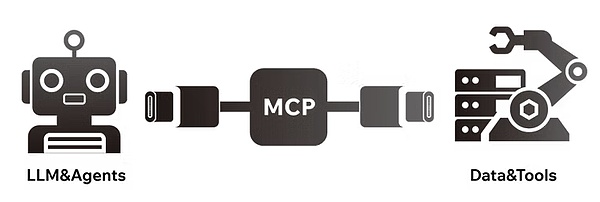

MCP lấp đầy những khoảng trống về khả năng nêu trên bằng cách hoạt động như một lớp giao diện chung, cho phép các tác nhân AI sử dụng nhiều công cụ khác nhau. Bạn có thể so sánh MCP với USB-C trong lĩnh vực ứng dụng AI - một tiêu chuẩn giao diện thống nhất giúp AI dễ dàng kết nối với nhiều nguồn dữ liệu và mô-đun chức năng khác nhau.

Hãy tưởng tượng mỗi LLM là một chiếc điện thoại khác nhau - Claude sử dụng USB-A, ChatGPT sử dụng USB-C và Gemini có giao diện Lightning. Nếu bạn là nhà sản xuất phần cứng, bạn phải phát triển một bộ phụ kiện cho mỗi giao diện, điều này có chi phí bảo trì cực kỳ cao.

Đây chính xác là vấn đề mà các nhà phát triển công cụ AI phải đối mặt: việc tùy chỉnh các plug-in cho từng nền tảng LLM làm tăng đáng kể tính phức tạp và hạn chế khả năng mở rộng. MCP được thiết kế để giải quyết vấn đề này bằng cách thiết lập một tiêu chuẩn thống nhất, giống như việc yêu cầu tất cả các LLM và nhà cung cấp công cụ sử dụng giao diện USB-C.

Giao thức chuẩn hóa này có lợi cho cả hai bên:

Đối với AI Agent (máy khách) : có thể truy cập an toàn vào các công cụ bên ngoài và nguồn dữ liệu thời gian thực

Đối với nhà phát triển công cụ (máy chủ) : truy cập một lần, khả dụng trên nhiều nền tảng

kết quả cuối cùng là một hệ sinh thái AI cởi mở hơn, có khả năng tương tác cao hơn và ít ma sát hơn.

Sự khác biệt giữa MCP và API truyền thống là gì?

API được thiết kế để phục vụ con người, không phải ưu tiên AI. Mỗi API đều có cấu trúc và tài liệu riêng và các nhà phát triển phải chỉ định thủ công các tham số và đọc tài liệu giao diện. Bản thân AI Agent không thể đọc tài liệu và phải được mã hóa cứng để thích ứng với từng API (như REST, GraphQL, RPC, v.v.).

MCP tóm tắt các phần không có cấu trúc này bằng cách chuẩn hóa định dạng gọi hàm trong API và cung cấp phương thức gọi thống nhất cho Agent. Bạn có thể coi MCP như một lớp điều chỉnh API bao bọc Autonomous Agent. Khi Anthropic lần đầu ra mắt MCP vào tháng 11 năm 2024, các nhà phát triển sẽ cần triển khai máy chủ MCP trên thiết bị cục bộ của họ. Vào tháng 5 năm nay, Cloudflare đã công bố tại Tuần lễ dành cho nhà phát triển rằng các nhà phát triển có thể triển khai trực tiếp máy chủ MCP từ xa trên nền tảng Cloudflare Workers với cấu hình thiết bị tối thiểu. Điều này giúp đơn giản hóa đáng kể quá trình triển khai và quản lý máy chủ MCP, bao gồm xác thực và truyền dữ liệu, có thể được gọi là "triển khai chỉ bằng một cú nhấp chuột".

Mặc dù bản thân MCP có vẻ không đủ "hấp dẫn", nhưng nó không hề tầm thường. Là một thành phần cơ sở hạ tầng thuần túy, MCP không thể được người tiêu dùng sử dụng trực tiếp. Giá trị của nó chỉ thực sự được bộc lộ khi tác nhân AI cấp cao gọi công cụ MCP và chứng minh kết quả thực tế.

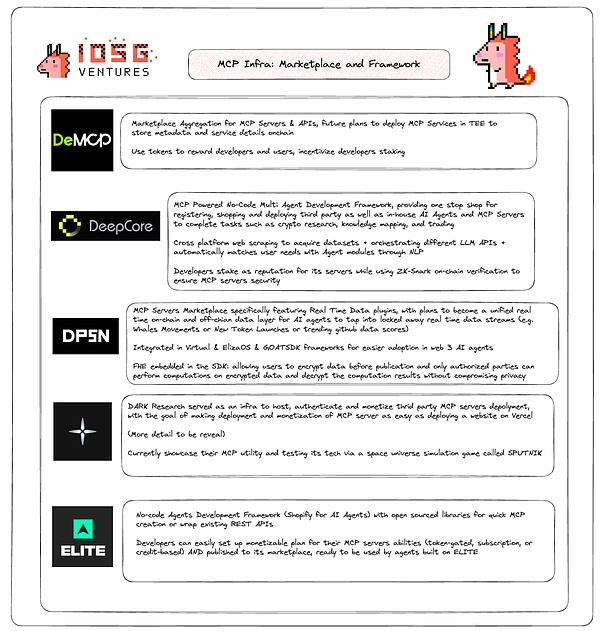

Cảnh quan sinh thái AI x MCP trên Web3

AI trong Web3 cũng phải đối mặt với các vấn đề về "thiếu dữ liệu theo ngữ cảnh" và "các đảo dữ liệu", nghĩa là AI không thể truy cập dữ liệu thời gian thực trên chuỗi hoặc thực thi logic hợp đồng thông minh một cách tự nhiên. Trước đây, các dự án như ai16Z, ARC, Swarms và Myshell đã cố gắng xây dựng một mạng lưới cộng tác đa tác nhân, nhưng cuối cùng lại rơi vào tình thế tiến thoái lưỡng nan là phải "phát minh lại bánh xe" do phụ thuộc vào API tập trung và tích hợp tùy chỉnh.

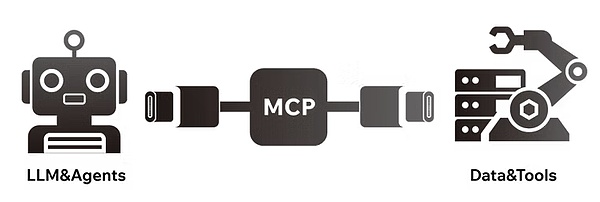

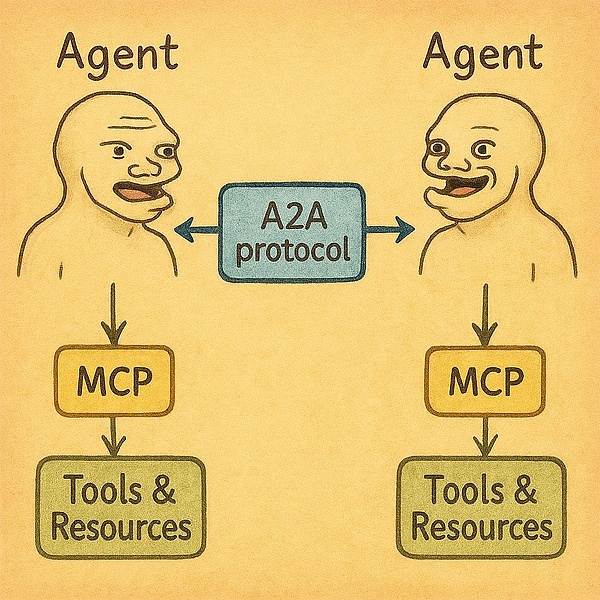

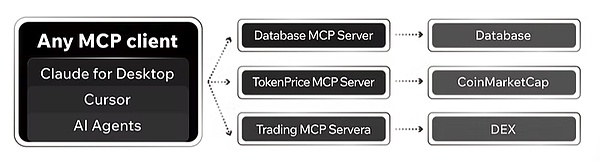

Lớp thích ứng phải được viết lại mỗi khi kết nối nguồn dữ liệu, dẫn đến tăng đột biến chi phí phát triển. Để giải quyết tình trạng tắc nghẽn này, thế hệ tác nhân AI tiếp theo cần có kiến trúc dạng mô-đun giống Lego hơn, cho phép tích hợp liền mạch các công cụ và plug-in của bên thứ ba. Do đó, một thế hệ cơ sở hạ tầng và ứng dụng AI Agent mới dựa trên giao thức MCP và A2A đang nổi lên, được thiết kế riêng cho các tình huống Web3, cho phép các Agent truy cập dữ liệu đa chuỗi và tương tác trực tiếp với các giao thức DeFi.

▲ Nguồn: IOSG Ventures

(Hình ảnh này không bao gồm đầy đủ tất cả các dự án Web3 liên quan đến MCP)

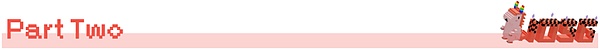

Các trường hợp dự án: DeMCP và DeepCore

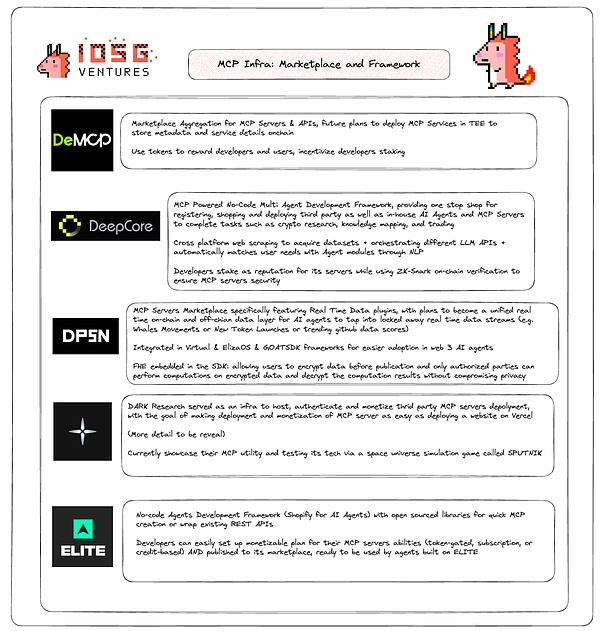

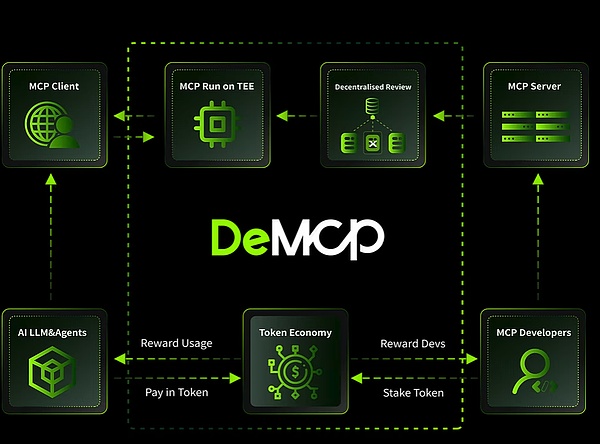

DeMCP là một thị trường Máy chủ MCP phi tập trung (https://github.com/modelcontextprotocol/servers), tập trung vào các công cụ mã hóa gốc và đảm bảo chủ quyền của các công cụ MCP.

Ưu điểm của nó bao gồm:

Sử dụng TEE (Môi trường thực thi đáng tin cậy) để đảm bảo rằng các công cụ MCP không bị can thiệp Sử dụng cơ chế khuyến khích mã thông báo để khuyến khích các nhà phát triển đóng góp vào máy chủ MCP

Cung cấp chức năng tổng hợp MCP và thanh toán nhỏ để hạ thấp ngưỡng sử dụng

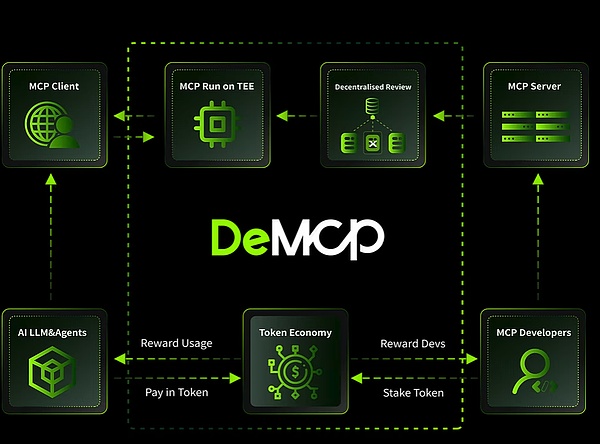

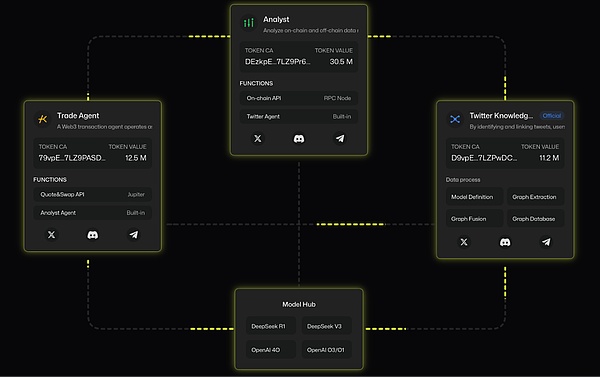

Một dự án khác DeepCore (deepcore.top) cũng cung cấp hệ thống đăng ký Máy chủ MCP, tập trung vào lĩnh vực mã hóa và mở rộng hơn nữa sang một tiêu chuẩn mở khác do Google đề xuất:Giao thức A2A (Agent-to-Agent) (https://x.com/i/trending/1910001585008058782).

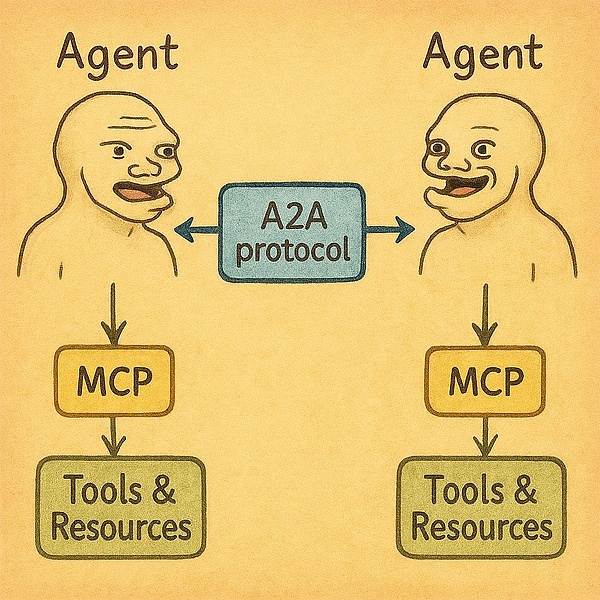

A2A là một giao thức mở được Google công bố vào ngày 9 tháng 4 năm 2025, nhằm mục đích đạt được khả năng giao tiếp, cộng tác và phối hợp nhiệm vụ an toàn giữa các tác nhân AI khác nhau. A2A cho phép cộng tác AI cấp doanh nghiệp, chẳng hạn như để các tác nhân AI từ các công ty khác nhau cùng làm việc trên các tác vụ (ví dụ: tác nhân CRM của Salesforce làm việc với tác nhân Jira của Atlassian).

Nếu MCP tập trung vào tương tác giữa Agent (máy khách) và công cụ (máy chủ), thì A2A giống như một lớp trung gian cộng tác giữa các Agent, cho phép nhiều Agent cùng hoàn thành nhiệm vụ mà không cần chia sẻ trạng thái nội bộ. Họ cộng tác thông qua ngữ cảnh, hướng dẫn, cập nhật trạng thái và truyền dữ liệu.

A2A được coi là "ngôn ngữ chung" cho sự cộng tác của tác nhân AI, thúc đẩy khả năng tương tác AI giữa nhiều nền tảng và nhiều đám mây, có thể thay đổi cách thức hoạt động của AI doanh nghiệp. Do đó, A2A có thể được coi như Slack trong thế giới tác nhân — một tác nhân khởi tạo một tác vụ và một tác nhân khác thực hiện tác vụ đó.

Tóm lại:

Tại sao máy chủ MCP cần blockchain?

Máy chủ MCP tích hợp công nghệ blockchain mang lại nhiều lợi ích:

1. Thu thập dữ liệu đuôi dài thông qua cơ chế khuyến khích gốc từ tiền điện tử , khuyến khích cộng đồng đóng góp các tập dữ liệu khan hiếm

2. Bảo vệ chống lại các cuộc tấn công "đầu độc công cụ" , tức là các công cụ độc hại được ngụy trang thành các plug-in hợp pháp để đánh lừa các Đại lý

Chuỗi khối cung cấp các cơ chế xác minh mật mã, chẳng hạn như Chứng thực từ xa TEE, ZK-SNARK, FHE, v.v.

Để biết chi tiết, vui lòng tham khảo bài viết này (

Tuy nhiên, dự án MCP vẫn đang trong giai đoạn đầu. Hầu hết các nền tảng vẫn là thị trường plug-in tập trung, nơi chủ sở hữu dự án tự tổ chức các công cụ máy chủ của bên thứ ba từ GitHub và tự phát triển một số plug-in. Về bản chất, chúng không khác nhiều so với thị trường plug-in Web2. Điểm khác biệt duy nhất là chúng tập trung vào các kịch bản Web3.

Xu hướng tương lai và tác động của ngành

Hiện nay, ngày càng nhiều người trong ngành mã hóa bắt đầu nhận ra tiềm năng của MCP trong việc kết nối AI và blockchain. Ví dụ, người sáng lập Binance CZ gần đây đã công khai kêu gọi các nhà phát triển AI tích cực xây dựng Máy chủ MCP chất lượng cao để cung cấp một bộ công cụ phong phú hơn cho các tác nhân AI trên Chuỗi BNB. Danh sách dự án Máy chủ MCP của BNB đã được công khai để người dùng tham khảo khi khám phá hệ sinh thái.

Khi cơ sở hạ tầng hoàn thiện,lợi thế cạnh tranh của các công ty "ưu tiên nhà phát triển" sẽ chuyển từ thiết kế API sang: ai có thể cung cấp một bộ công cụ phong phú hơn, đa dạng hơn và dễ kết hợp hơn.

Trong tương lai, mọi ứng dụng đều có thể trở thành máy khách MCP và mọi API đều có thể là máy chủ MCP.

Điều này có thể dẫn đến một cơ chế định giá mới: Các tác nhân có thể lựa chọn động các công cụ dựa trên tốc độ thực hiện, hiệu quả về chi phí, mức độ liên quan, v.v., hình thành nên một hệ thống kinh tế dịch vụ tác nhân hiệu quả hơn được hỗ trợ bởi Crypto và blockchain như một phương tiện.

Của Tất nhiên, bản thân MCP không trực tiếp đối mặt với người dùng cuối, nó là một lớp giao thức cấp thấp. Nói cách khác, giá trị thực sự và tiềm năng của MCP chỉ có thể thực sự được nhìn thấy khi AI Agent tích hợp nó và biến nó thành các ứng dụng thực tế. Cuối cùng, Agent là đơn vị vận chuyển và khuếch đại các khả năng của MCP, trong khi blockchain và các cơ chế mã hóa xây dựng một hệ thống kinh tế đáng tin cậy, hiệu quả và có thể cấu thành cho mạng lưới thông minh này.

Weatherly

Weatherly