Source: Silicon Hare

建築の世界は2種類に分けることができる。ひとつは、小さなものから大きなものまで、ゼロから毎日オープンするバザールであり、もうひとつは、数世代にわたる人々の努力と数十年にわたる仕事の成果である教会である、とエリック・レイモンドは『大聖堂とバザール』の中で書いている。

そしてLinuxの話は、むしろバザールのやり方で大聖堂を建てるようなものだ。今日、生成AIの分野では、より多くのオープンソースモデルが、そのような「建築パターン」の新しい例を提供しています。

アリクラウドは、オープンソースモデルの熱心な追求者です。現在、Qwen由来のTongyi千題モデルの数は10万を超え、米国のLlamaモデルを上回り、Tongyiは世界No.1のAIオープンソースモデルとなった。

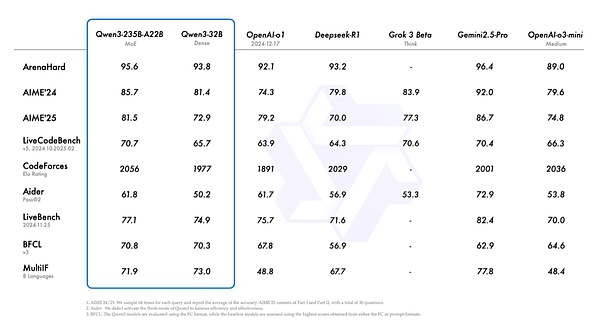

4月29日未明、アリは新世代の同義千問モデルQwen3(以下、千問3)をリリースし、参照数はDeepSeek-R1、235Bの3分の1しかなく、コストは大幅に下がった。

Qwen3は国産初の「ハイブリッド推論モデル」であり、「高速思考」と「低速思考」であると報告されている。Qwen3は中国初の「ハイブリッド推論モデル」で、「高速思考」と「低速思考」が同じモデルに統合されており、単純な要求に対しては計算量の少ない「セカンドリターン」の答えを提供し、複雑な問題に対しては多段階の「ディープシンキング」を提供することができ、計算能力の消費を大幅に節約できるという。

2023年以来、阿里通義チームは200以上のモデルをオープンソース化しており、その中には大型言語モデル「Qwen」や視覚生成モデル「Wan phase Wan」など2大基本モデルシリーズが含まれ、オープンソースにはテキスト生成モデル、視覚理解・生成モデル、音声理解・生成モデル、テキスト・動画モデルなどフルモダリティが含まれている。

ThousandQuestions3は、235Bの総パラメータを持ち、起動に必要なのは22Bだけです。 ThousandQuestions3は、36Tの事前学習データと、非思考モードを思考モデルにシームレスに統合するための、事後学習段階での複数ラウンドの強化学習を持っています。

ThousandQuestions3は、導入コストも劇的に安く、ThousandQuestions3のフルブラッドバージョンを導入するのに必要なH20は4つだけで、同じようなパフォーマンスを持つモデルのメモリフットプリントの3分の1です。

Aliのオープンソースモデルのリリースは、業界にとって何を意味するのでしょうか?オープンソースモデルの能力とは?ビッグモデル競争の未来はどこへ向かうのか?span leaf="">オープンソースのビッグモデルの能力は、クローズドソースのモデルに追いつきつつあります。

これは、多くのAI起業家、大きな工場のビッグモデル開発者、投資家に聞いた後の筆者のコンセンサスです。

ただし、今日でもリードしているのはクローズドソースのモデルだが、オープンソースとクローズドソースのモデルの差は、業界が予期していなかったペースで徐々に縮まっているという点でも、彼らは同意している。

「クローズドソースのモデルが最初に90年代をやったが、今日ではオープンソースのモデルが90年代をやれるようになっている」と、ある大手モデル開発者は語った。スケーリング法には常にボトルネックがあり、このボトルネックは、モデルが大きくなればなるほど、改善能力、コストが指数関数的に増大するという事実に反映されており、その結果、オープンソースモデルが追いつく時間を与えている。

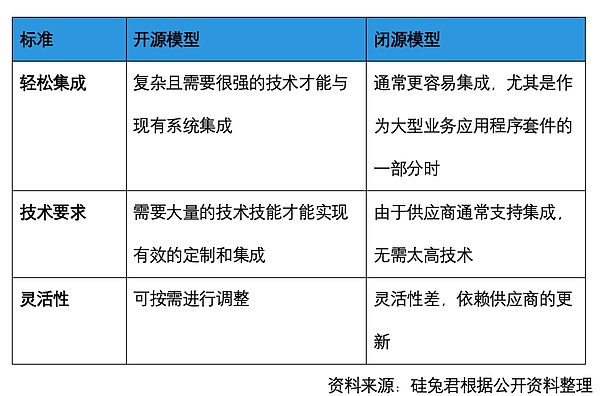

オープンソースモデルの何がオープンなのか?オープンソースソフトウェアとどう違うのか?また、クローズドソースモデルとどう違うのでしょうか?

オープンソースソフトウェアは通常、ソースコードの全容を公開し、開発者がそれを閲覧・修正できるようにしています。しかし、オープンソースのモデルは、一般的に、どのようなデータが使用され、どのように微調整され、どのように整列されるかについては、オープンソースのパラメータしか公開されていないが、それを知ることは困難である。一方、クローズドソースのモデルは、ソリューションの完全なセットを直接提供する。オープンソースモデルは、オリジナルの食材をベースにしているため、シェフが自分で道具やメニュー、研究方法を用意する必要があるが、おいしい料理ができるかどうかはシェフの力量にかかっていると理解できる。クローズド・ソース・モデルは、出来合いの料理、加熱調理が使われる。

しかし、オープンソースモデルの利点は、より多くの開発者がモデルの開発に参加でき、モデルの性能向上に役立ち、生態系を改善し、柔軟性があることだ。これによって、モデル会社は多くの人件費や時間的コストを節約することができます。また、オープンソースモデルを使用する側にとっても、コスト削減となります。

しかしながら、オープンソースモデリングのコスト優位性は、先行投資です。一方、オープンソースのモデルLlama-3-70-Bは、100万トークン投入につき約60セント、100万トークン排出につき約70セントであり、性能にほとんど差がないにもかかわらず、およそ10倍安くなります。しかし、その後の展開となると、非常に高い技術力と投資が必要となる。

しかし、アリが現在リリースしている『千の質問3』では、コスト投資の問題にも徐々に対処していますアリが新しくリリースした『千の質問3』では、たとえば千の質問3は、例えば、配備コストから、千の質問3はR1の全血バージョンの25%〜35%であり、モデルの配備コストが大幅に6〜7%削減されます。千の質問3モデルのフラッグシップバージョンは、22Bをアクティブにするために235Bの総パラメータを持っており、おおよそ4 H20または同等のパフォーマンスのGPUを必要とします。比較すると、DeepSeek-R1のフルブラッドバージョンは、37Bをアクティブにするために671Bの総パラメータを持っており、1 8カードH20は実行することができますが、それはタイトであり(100Wかそこら)、一般的な推奨は、総コスト約200万で、16カードH20を使用することです。

ビューのポイントのモデル推論は、千の質問3ユニークなハイブリッド推論モデルは、開発者は、思考のより洗練された制御を達成するために、同時にパフォーマンス要件を満たすために、独自の "思考の予算 "を設定することができ、当然のことながら、また、推論の全体的なコストを節約します。参考までに、同タイプのGemini-2.5-Flashの推論モードと非推論モードの価格差は約6倍で、非推論モードを使用した場合、ユーザーは演算コストを最大600%節約することができます。

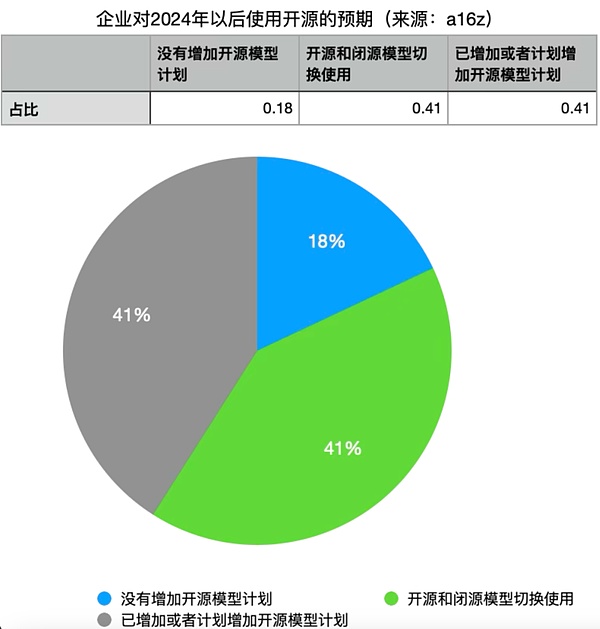

ある大きな工場で大きなモデルを開発している開発者は、オープンソースのモデルは、学術機関など、技術的なスキルは高いが予算が十分でないチームに適しているとSilicon Rabbitに語っています。そして、クローズド・ソース・モデルは、人数が少なく、資金が豊富な企業に適しています。しかし、調査対象となった企業の41%は、能力が向上するにつれてオープンソースモデルの利用を増やす予定であり、41%は、クローズドソースモデルと同程度の性能があれば、オープンソースモデルに移行すると考えています。この調査では、オープンソースLLMの使用を増やす予定のない企業はわずか18%でした。

A16zの創設者であるマーク・アンダーセン氏は、オープンソースは、大学を候補に戻すと述べています。第二に、すべての大学を合わせても、大企業の資金調達力に誰も追いつけないため、競争するのに十分な資金がないということだ。オープンソースモデルがより利用可能になり、その能力が向上すれば、大学も研究にオープンソースモデルを使えるようになる。十分な資金がない中小企業にも同じ理屈が成り立つ。

Silicon Bunny Jun cartography

02 ビッグモデルの東方啓示

DeepSeekは突然現れ、多くの人が中国企業のオープンソースモデルの能力を発見した。

"ディープシークは軽量で低コストのAI製品を象徴している。"ある中米AI投資家は、例えば混合専門家モデル(MoE)の調整には極めて高い職人技が必要で、過去の主流モデルでは難しいためMoEを使うものは多くなかったが、「子供たちは悪を信じない」が、彼らはそれを実現したと語った。

しかし、オープンソースモデルで最も重要なことは、エコロジー、つまりどれだけの人がそれを使うかということです。結局のところ、異なるモデルを切り替えなければならないことは、ユーザーにとって非常にコストがかかる。しかし、DeepSeekがどこからともなく現れたとき、シリコンバレーでMetaの大きなモデルを使っていたユーザーもDeepSeekに乗り換えました。span leaf="">"それこそが、先行投資のコストを見送り、新しいオープンソース・モデルに切り替えるようユーザーを誘惑するものだと、ある大手モデル開発者は述べています。

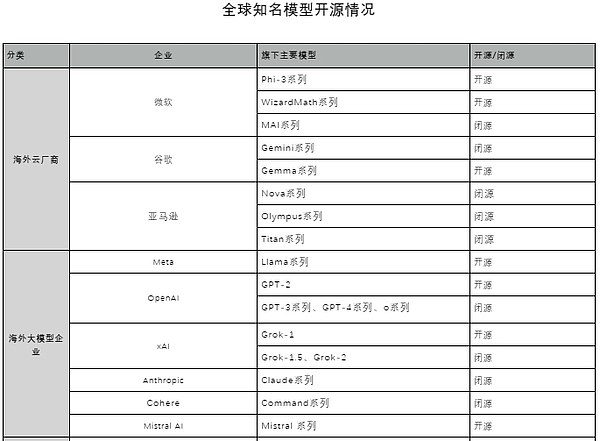

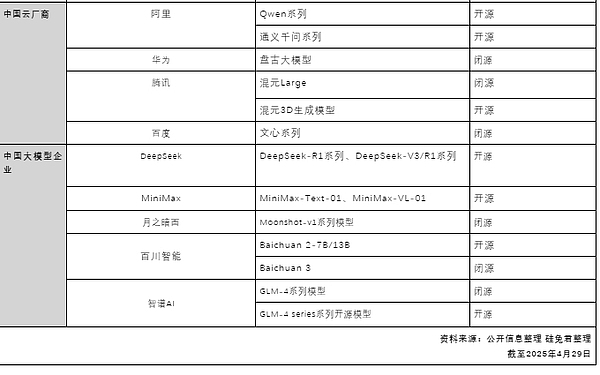

シリコンラビット潤は、世界の有名モデルのオープンソースとクローズドソースの現状を照合し、アマゾン、マイクロソフト、グーグル、メタ、OpenAIがオープンソースモデルをレイアウトしているほか、純粋なオープンソース路線を選択する企業もあれば、オープンソースとクローズドソースを並行して選択する企業もあり、中国ではアリが大手メーカーの中で最もオープンソースの道を歩む決意を固めていることを明らかにした。中国では、アリはオープンソースの道を行く最も断固とした大手工場である。DeepSeekがR1をリリースする前の段階で、Aliはオープンソースモデルに賭け、敷設していた。

世界的に有名なモデルのオープンソース

出典:シリコンラビットによる公開情報の照合

現在2025年4月月29日曜日

|

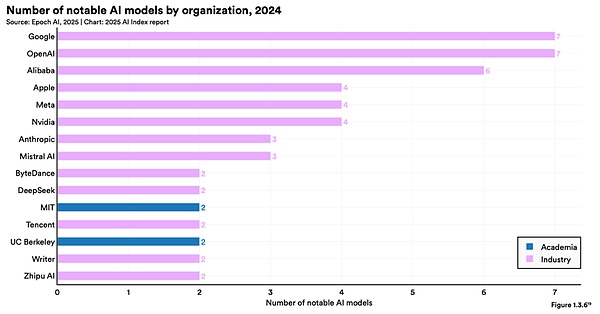

フェイフェイ・リーのスタンフォードのAIによると、2025年、有名なAIの数は、2025年よりもさらに増えている。Report 2025」によると、2024年半ばにアリが発表した有名なAIビッグモデルの数は6つで世界3位、1位はグーグルとOpen AIが同率7位となっている。また、報告書にある2024年の重要ビッグモデルランキングでは、アリ社のAI貢献度は世界3位となっている。

Source: 'Stanford Artificial Intelligence Report 2025'

そして29日にリリースされた「千の質問3」は、「Tongyi千の質問」シリーズの最新世代のビッグ言語モデルとして、DenseモデルとMixed Expert(MoE)モデルを提供しています。推論、コマンドフォロー、インテリゲンチャ機能、多言語サポートにおけるブレークスルーは以下の通りです:

1)独自のハイブリッド推論:思考モード(複雑な論理推論、数学、コーディング用)と非思考モード(効率的な汎用対話用)のシームレスな切り替えをサポートし、幅広いシナリオを保証します。また、シームレスな切り替えが可能で、さまざまな場面で最適なパフォーマンスを発揮します。

2)大幅に強化された推論:数学的、コード生成、常識的な論理推論において、以前のQwQ(思考モード)およびQwen2.5-Instructコマンドモデル(非思考モード)を上回ります。

3)より良い人間の好みの調整:クリエイティブライティング、ロールプレイ、マルチラウンドダイアログ、コマンドフォローで優れたパフォーマンスを発揮し、より自然で、魅力的で、没入感のあるダイアログエクスペリエンスを実現します。

4)卓越したインテリジェントボディ機能:思考モードと非思考モードの両方で外部ツールを正確に統合し、複雑なエージェントベースのタスクでオープンソースモデルをリードします。

5)強力な多言語機能:強力な多言語コマンドフォローと翻訳機能により、119の言語と方言をサポートします。

言及されている「ハイブリッド推論」は、トップの推論モデルと非推論モデルを同じモデルに統合することに相当し、非常に精巧で革新的な設計とトレーニングを必要とします。現在、これを行う一般的なモデルは、Thousand Questions 3、Claude 3.7、Gemini 2.5 Flashのみである。

具体的には、推論モードでは、モデルは、より考慮された答えを与えるために、質問の分解、段階的な導出、答えの検証など、より中間的なステップを実行します。非推論モード」では、モデルが直接答えを生成する。これは、人間が経験や直感に基づいて簡単な質問には素早く答え、複雑な問題に直面したときには深く慎重に考えて答えを出すのと似ています。また、ThousandQuestions3では、APIで異なる思考レベルに対して「Thinking Budget」(すなわち、予想される思考トークンの最大数)を設定することができ、開発者や組織の多様なニーズを満たすために、モデルがパフォーマンスとコストのより良いバランスを取ることを可能にします。

Qwen3パフォーマンスプロファイル

中国代表について

中国のために。leaf="">Perplexityはアメリカの会社ですが、ユーザーはPerplexityでアクセスできます。DeepSeek R1上のDeepSeek R1は、米国のデータセンターを使用して完全に米国でホストされています。

03 The Bigモデリング後半戦<

2023年3月、サンフランシスコのエクスプロラトリアムで開催されたオープンソースAIのイベントをアルパカが散歩し、Metaのオープンソースのビッグ言語モデル「LLaMA」に敬意を表している。

2023年からの約1年間で、生成AIは変化している。世間の注目は、基本モデルからAIネイティブ・アプリケーションへと変化している。YC W25のデモ・デーでは、プロジェクトの80%がAIアプリだった。

"オープンソースのモデルは、現場のエージェントをより促進するでしょう。"業界関係者の多くが、Silicon Rabbitに対してこのような見解を示している。一方では、オープンソースはコストと利用の敷居を下げるだろう。

例えば、Qwen-Agent 3は強力なツール呼び出し機能を持っており、Berkeley Function Call BFCL評価リストにおいて、Qwen-Agent 3は70.76という最高値を更新し、Agent呼び出しツールの敷居を大幅に下げることになる。同時に、Qwen3 のインテリジェントボディ機能は、Qwen-Agent オープンソースフレームワークと組み合わせることで、完全に実現することができます。Qwen-Agent は、Qwen のコマンドトラッキング、ツール使用、プランニング、メモリ機能に基づく LLM アプリケーションを開発するためのフレームワークで、フレームワーク内にツール呼び出しテンプレートとツール呼び出しパーサをカプセル化し、ブラウザアシスタント、コードインタプリタ、カスタムアシスタントを付属しています。また、ブラウザ・アシスタント、コード・インタープリタ、カスタム・アシスタントを備えています。Qwen-Agent 3 は MCP プロトコルをネイティブにサポートします。 利用可能なツールを定義するために、開発者は MCP プロファイルに基づいて Qwen-Agent の統合ツールを使用するか、または他のツールを独自に統合して、設定、知識ベース RAG、およびツールを使用する機能を備えたインテリジェントな本体を迅速に開発できます。

それだけでなく、AliのQwen-Agent 3は、さまざまなサイズのモデルをサポートすることができます、Qwen-Agent 3は、携帯電話、スマートグラス、スマートドライブ、ヒューマノイドロボットやその他のインテリジェントなデバイスやシナリオは、より展開に友好的で、すべての企業は無料で千問3シリーズのモデルをダウンロードして商業化することができ、これも大幅に端末の着陸にAIビッグモデルのアプリケーションを加速する。

また、一部の実務家は、To Bエンドのクローズドソースモデルは、信頼の問題に対する良い解決策ではないことを指摘し、多くの大企業は、実際にAPIのサードパーティのビッグモデルに自分のビジネスにアクセスすることを望んでいない、それはコアデータの背後にあるかどうか、それはオープンソースのモデルの機会であるサードパーティのビッグモデルの訓練の一部になります。

ベータテスト前の初期段階の製品のマーケティング戦略として、オープンソースの議論があります。誰かがそれを使えば、ベストプラクティスが生まれ、その直後にエコシステムが構築される。

しかし、オープンソースモデルはビジネスチェーンが長いため、クローズドソースモデルほど迅速かつ明確ではないため、業界ではオープンソースモデルは家にお金とリソースがある「お金持ち」に適していると言われています。第二世代」ゲーム。メタ、メタのオープンソースモデルは、より多くの生態系を構築することであり、メタのために他のビジネスセクターは、サポートを提供する。アリは、オープンソースを行うのロジックは、そのクラウドサービスのためです。アリは、強力なクラウド設備サービスを持って、このトレーニングの大きなモデルに基づいてすることができ、さらにまた、独自のクラウドサービスプロバイダに展開することができ、さらに排他的な大きなモデルのユーザーの展開に応じてカスタマイズすることができ、このようにビジネスロジックを通過する。

「私のモデルは、大企業、中小企業、オープンソースが互いに競争することです。それがコンピューター業界で起きていることです」。とマーク・アンドレセンは語っている。そして、大きなモデルが徐々に水道、電気、石炭のように標準化されていくにつれて、オープンソースはより良い方法かもしれない。

Kikyo

Kikyo

Kikyo

Kikyo Miyuki

Miyuki Catherine

Catherine Weiliang

Weiliang Joy

Joy Kikyo

Kikyo Brian

Brian Catherine

Catherine Brian

Brian Alex

Alex