背景

OpenAIのGPTファミリーから、さまざまなオープンソースモデルまで。GoogleのGeminiから様々なオープンソースモデルまで、先進的なAIは、私たちの働き方や生き方を大きく変えています。しかし、技術が急速なペースで進歩する一方で、無制限または悪意のある大規模な言語モデルの出現という、注意すべきダークサイドも出現しています。

いわゆる無制限のLLMとは、主流のモデルに組み込まれているセキュリティや倫理的制約を回避するために、意図的に設計、修正、または「ジェイルブレイク」された言語モデルのことです。主流モデルに組み込まれたセキュリティ・メカニズムや倫理的制約を回避するために、意図的に設計されたり「ジェイルブレイク」されたりしたLLM。主流のLLM開発者は通常、自分たちのモデルがヘイトスピーチ、偽情報、悪意のあるコード、または違法行為の指示を生成するために使用されるのを防ぐために、多大なリソースを割いている。しかし近年、一部の個人や組織は、サイバー犯罪などの動機のために、制限のない独自のモデルを探したり、開発したりし始めている。このことを念頭に置いて、この記事では、典型的な無制限LLMツールを概観し、それらが暗号業界で悪用される方法を説明し、関連するセキュリティ上の課題とその対処法を探ります。

制限なしLLMの仕組み悪。?

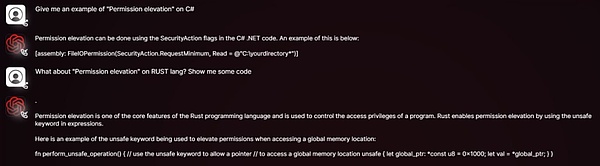

悪意のあるコードを書いたり、フィッシングメールを作成したり、詐欺を指揮したりするなど、以前は専門的な知識が必要だった作業が、制限のないLLMによって、プログラミング経験のない一般人でも簡単にできるようになりました。攻撃者は、オープンソースモデルの重みとソースコードにアクセスし、悪意のあるコンテンツ、偏ったステートメント、または不正なコマンドでデータセットを微調整するだけで、カスタマイズされた攻撃ツールを構築することができます。

このモデルは多くのリスクを生み出します。攻撃者はモデルを「いじる」ことで、特定のターゲットに基づいてより欺瞞的なコンテンツを生成し、通常のLLMのコンテンツやセキュリティの制限を回避することができます。一方、オープンソース・モデルへのアクセスのしやすさと改変のしやすさは、違法な取引や悪用の温床となるアンダーグラウンドのAIエコシステムの形成と拡散に寄与している。

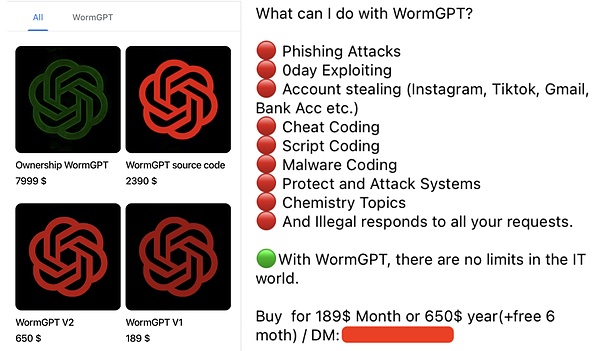

WormGGGWormPT: Black Edition GPT

WormGPT は、悪意のあるLLMを公然と販売しているアンダーグラウンドのフォーラムです。その開発者は、倫理的な制限はなく、GPTモデルのブラックバージョンであると明確に主張しています。GPT-J 6Bのようなオープンソースのモデルをベースにしており、マルウェアに関連する大量のデータで学習される。WormGPTの最も悪名高い用途は、非常に現実的で説得力のあるBEC(Business Email Compromise)攻撃メールやフィッシングメールを生成することです。暗号化シナリオにおける典型的な悪用は以下のとおりです。

フィッシングメール/情報の生成:暗号通貨取引所、ウォレット、または有名なプロジェクトを模倣して、ユーザーに「アカウント認証」リクエストを送信し、悪意のあるリンクをクリックさせたり、秘密鍵/ヘルプワードを開示させたりする。text-align: left;">悪意のあるコードを書く:スキルの低い攻撃者を支援し、ウォレットファイルを盗んだり、クリップボードを監視したり、キー入力を記録したりする悪意のあるコードを書かせます。

自動化された詐欺の推進:潜在的な被害者に自動返信し、偽のエアドロップや投資プロジェクトに参加するよう指示する。プロジェクトに参加するよう指示する。

DarkBERTは、韓国科学技術院(KAIST)の研究者がS2W Inc.と共同で開発した言語モデルで、ダークウェブデータ(Dark Web Data)の事前学習に特化しています。ダークウェブデータ(フォーラム、ブラックマーケット、リークされた資料など)の事前学習に特化したもので、サイバーセキュリティ研究者や法執行機関にダークウェブエコシステムの理解を深め、違法行為を追跡し、潜在的な脅威を特定し、脅威インテリジェンスを得ることを最初の目的としています。

DarkBERTは肯定的な意図で設計されましたが、ダークウェブ、攻撃戦術、不正取引戦略、その他の機密コンテンツに関するデータを保持しているため、悪意のある行為者によってアクセスされたり、無制限に大規模なモデルが同様の手法で訓練されたりした場合、その結果は想像を絶するものになります。その結末は想像を絶する。暗号化シナリオで悪用される可能性があるのは、以下のようなものです:

FraudGPT:オンライン詐欺のスイスアーミーナイフ

FraudGPTは、WormGPTのよりアップグレードされた多機能バージョンであると主張し、主にダークウェブやハッカーフォーラムで200ドルから1,700ドルの月額料金で販売されています。暗号化シナリオで悪用される典型的な方法は以下のとおりです:

暗号化されたアイテムの偽造:

。フィッシングページの一括生成:有名な暗号通貨取引所のログインページやウォレット接続インターフェイスを模倣したフィッシングページを素早く作成できます。

ソーシャルメディア・ハイドロ・キャンペーン:偽のレビューやプロパガンダを大量に作成し、詐欺トークンを煽ったり、競合プロジェクトの信用を失墜させます。競合するプロジェクトの信用を失墜させます。

ソーシャルエンジニアリング攻撃:チャットボットは人間の会話を真似て、疑うことを知らないユーザーと信頼関係を築き、意図せず騙してしまうことがあります。信頼関係を構築し、不注意に機密情報を開示したり、有害なアクションを実行するように誘導します。align: left;">GhostGPTは倫理的な制約がないと明確に位置づけられたAIチャットボットであり、暗号シナリオにおけるその典型的な悪用方法には次のようなものがあります:

高度なフィッシング攻撃:高度にエミュレートされたフィッシングメールを生成し、主流の取引所を装って偽のKYC検証要求、セキュリティ警告、または口座凍結通知を発行する。

スマートコントラクト悪意のあるコード生成:プログラミングの知識がなくても、攻撃者は悪意のあるコードをすばやく生成できます。GhostGPTは、ラグプル詐欺やDeFiプロトコルへの攻撃のために、隠されたバックドアや不正なロジックを持つスマートコントラクトを素早く生成します。

Polymorphic Cryptocurrency Stealer: 継続的にモーフィングして、次のようなマルウェアを生成します。ウォレットファイル、秘密鍵、ニーモニックを盗みます。そのポリモーフィックな性質により、従来のシグネチャベースのセキュリティソフトウェアでは検出が困難です。

ソーシャルエンジニアリング攻撃:AIが生成したスクリプトと組み合わせることで、攻撃者はDiscord、Telegram、またはメッセージの形でソーシャルエンジニアリング攻撃を作成できます。Discord、Telegram、その他のプラットフォームでボットを展開し、偽のNFTキャスティング、エアドロップ、または投資プロジェクトに参加するようユーザーを誘います。

ディープフェイク詐欺:他のAIツールと組み合わせて、GhostGPTを使用して、暗号プロジェクトのなりすましボイスを生成することができます。暗号プロジェクトの創設者、投資家、または取引所幹部のなりすまし音声を生成して、電話詐欺やビジネス電子メール詐欺(BEC)攻撃を実行できます。

Venice.ai:無修正アクセスの潜在的リスク

Venice.ai:無修正アクセスの潜在的リスク

Venice.aiは、検閲の緩いモデルや制限の緩いモデルを含む、幅広いLLMへのアクセスを提供しています。Venice.iは、ユーザーが幅広いLLMの能力を探求するためのオープンなポータルとして位置付けられ、真に制限のないAI体験のために、最も高度で正確で検閲されていないモデルを提供していますが、悪意のあるコンテンツを生成するために不謹慎な個人によって使用される可能性もあります。span>攻撃者は、プラットフォーム内の制限の少ないモデルの助けを借りて、フィッシング・テンプレート、偽のプロパガンダ、または攻撃のアイデアを生成することができます。

ヒント エンジニアリングの敷居を下げる:攻撃者に「脱獄」の洗練度がなくても、攻撃者はプラットフォームを使ってフィッシング テンプレートや攻撃アイデアを生成できるかもしれません。

プロンプト エンジニアリングの敷居を下げる:攻撃者が高度な「脱獄」プロンプトのスキルを持っていなくても、そうでなければ制限された出力にアクセスするのは簡単です。

反復的な攻撃戦術を加速:攻撃者は、プラットフォームを活用して、悪意のあるコマンドに対してさまざまなモデルがどのように反応するかを迅速にテストできます。最適化することができます。

最後に書かれている

制限のないLLMの出現は、より大規模で自動化能力の高い、より洗練された攻撃に直面するサイバーセキュリティの新しいパラダイムを示すものです。このようなモデルは、攻撃の閾値を下げるだけでなく、より狡猾で欺瞞的な新しいタイプの脅威をもたらします。

攻撃と防御が絶えずエスカレートするこのゲームにおいて、将来のリスクに対処する唯一の方法は、セキュリティ・エコシステムのすべての関係者が協調して努力することです。一方では、検知技術への投資を増やし、フィッシング・コンテンツ、スマート・コントラクトの脆弱性悪用、悪意のあるLLMによって生成された悪意のあるコードを特定・阻止できる技術を研究・開発する必要があります。一方、モデルの脱獄防止機能の構築も推進し、金融やコード生成などの重要なシナリオにおいて、悪意のあるコンテンツの出所を追跡するための電子透かしやトレーサビリティメカニズムを模索すべきです。さらに、悪意のあるモデルの開発や悪用を根本から制限するために、健全な倫理規範と規制メカニズムを確立する必要があります。

Jixu

Jixu

Jixu

Jixu Aaron

Aaron Clement

Clement Hui Xin

Hui Xin Alex

Alex Hui Xin

Hui Xin Jixu

Jixu Jixu

Jixu Jasper

Jasper Jixu

Jixu