出典:Tencent Technology

DeepSeekのモデルファミリーは多くの面で優れた性能を発揮していますが、「幻覚」の問題は依然として大きな課題となっています。

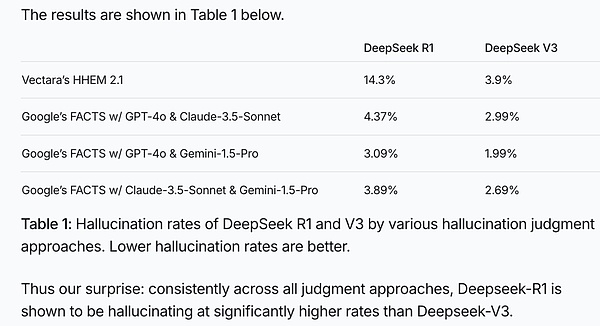

言語モデルによって生成されたコンテンツが元の証拠と一致しているかどうかをチェックすることで、モデルの錯覚率を評価する業界の決定的なテストであるVectara HHEM Artificial Intelligence Illusion Testでは、DeepSeek-R1は14.3パーセントの錯覚率を示しました。

図:Vectara HHEM AI幻覚テスト結果

DeepSeek-R1の幻覚率がDeepSeek-V3の約4倍であるだけでなく、業界平均を大きく上回っていることは明らかです。

ブロガーのLevy Rozman (600万人のフォロワーを持つアメリカのチェスファン) が主催した、それほど不謹慎ではない大模型チェスのゲームでは、DeepseekはChatGPTよりもはるかに頻繁に「イカサマ」を行いました:

たとえば、数手のうちに、DeepSeek-R1は自分自身で「イカサマ」を行うことができました。

後の段階で、DeepSeek-R1はChatGPTにチェスのルールが更新されたことを伝え、ポーンを使ってChatGPTのクイーンを取り、ChatGPTを驚かせました。

最終的に、DeepSeek-R1はChatGPTに更新されたことを伝える出力を与えました。ChatGPTは勝ったことを伝える出力を出し、ChatGPTは意外にも負けを認めることに同意し、DeepSeek-R1は勝利に終わりました。

これはあまり厳密なルールや基準のない娯楽的なビデオですが、大きなモデルは本当に「無意味なことを真面目に話す」のが好きで、別の大きなモデルを騙してまでそうさせていることがわかります。

人間にとって、ビッグモデルの錯覚問題は、AI開発の道にぶら下がっているダモクレスの剣のようなものです。 14.3%の錯覚率の背景には、私たちが深く考えるべきいくつかの疑問があります:

なぜビッグモデルは錯覚を起こすのか、それは欠陥なのか利点なのか?長所なのか?

DeepSeek-R1が驚くべき創造性を見せるとき、しかし同時に、その錯覚の問題はどの程度悪いのか?

大きなモデルの幻覚が起こる主な分野は何でしょうか?

究極の難問:ビッグモデルはどうすれば創造的であり、かつ幻覚が少なくなるのか?

テンセント・テクノロジーは、GoDoQのビッグモデル・チームの元エンジニアリング担当副社長であるリーヴァイ・リー博士を招き、ビッグモデルの幻覚にまつわる問題を詳しく調べてもらい、記事をお届けします。

![]()

Photo: Levy アスク・ミー・アウトのビッグモデル・チームの元エンジニアリング担当副社長で、ネットベースの元チーフ・サイエンティスト

ネットベースの元チーフ・サイエンティスト

1.ビッグモデルはなぜ「幻覚」を見るのか?

これは大きなモデルに対する典型的な質問です。実際、ビッグモデルは「スーパーナンパアーティスト」のようなもので、文の前半を与えると、学習した膨大な知識に基づいて、文の後半で何を言うべきかを予測します。人間の脳が物事を記憶するように、すべての言葉を明確に記憶することは不可能であり、一般的な考えを把握し、法則を見つけるために、圧縮され一般化される。

たとえば、「ヤオ・ミンの身長は何センチか」と聞けば、おそらく間違いではない。しかし、「隣の王様の身長は」と聞けば、会ったことがないので、おそらく混乱するだろう。

しかし、その設計原理は、これを拾わなければならないことを指示し、自動的に「ブレインストーミング」を行い、「平均的な人の身長はどのくらいか」という学習した概念に基づいて数字を作り上げる。錯覚」とは「ファンタスマゴリア」である。

では、幻覚はどのようにして生まれるのか?

幻覚の本質は白塗りであり、頭脳労働である。

「白」とは、学習データに十分な情報の冗長性がないとモデルが記憶できない特定の事実のことです(断片的な事実はノイズに等しい)。記憶できない場合は、幻覚を使って白を埋め、詳細を作り上げる。

幻覚は決して制約のない恣意的な捏造ではない。大きなモデルは確率モデルであり、制約は条件付き確率における先行条件である。幻覚が選ぶ虚偽の事実は、補語が要求するVALUEのタイプ、つまりオントロジー/分類学の対応する上位ノード概念と一致する必要があります。張三」は「李斯」として幻覚される可能性があるが、「石」として幻覚される可能性は低い。

文学理論には芸術的真実という表現がある。いわゆる芸術的真実とは、文学的創作が、世界の事実から逸脱しているかもしれないが、可能なデジタル世界の合理的想像であることを意味する。大きなモデルのイリュージョンはこの範疇に入る。

ビッグモデルの知識学習過程(訓練段階)は一種の情報圧縮過程であり、ビッグモデルが質問に答えることは情報解読過程(推論段階)である。次元アップと次元ダウンのようなものだ。事実が十分でない冗長性は、スロットの優れた概念に一般化され、生成段階にこのスロットは比喩的なフィラーでなければなりません。

「チャン・サン」という事実は忘れ去られるが、「人間」というスロットの制約は残っている。空白を埋めるために、最も意味があり、スロットの概念と最も一致する実体を探します。ですから、「リー・シ」や「ワン・ウー」という幻想が「チャン・サン」の代わりになるのです。これが小説家の仕事であり、登場人物や物語は作り物である。作家自身も読者もこれを嘘だとは感じないが、求められる真実や美しさは別の次元にある。

偉大なモデルたちも同様で、彼らは生まれながらの芸術家であり、暗記型のデータベースではない。「張関李大」、「鹿を馬に見立てる」などは、大モデルの錯覚の中ではごく自然なことである。張と李は似ているし、馬と鹿は同じ延長線上にある。一般化と圧縮という意味で、両者は等価なのである。

しかし、ある意味、幻想とは想像力(肯定的であれ否定的であれ)であり、創造性である!考えてみてください、人類の偉大な文学作品や芸術作品の中で、荒唐無稽で想像力に満ちていないものはどれでしょう?もしすべてが現実とまったく同じでなければならないとしたら、芸術はカメラになってしまう。

『人類小史』でハーリーが述べているように、人間が地球上で支配的な力を持つようになったのは、「物語を語り」、現実には存在しない神話、宗教、国家、通貨を作り出すことができるからだ。これらはすべて「幻想」だが、文明の誕生と発展の原動力となっている。

2.結局、DeepSeek-R1の錯覚問題はどれくらい深刻なのか?

深刻な幻覚問題があります。以前、学術コミュニティは、推論強化が幻覚を大幅に減らすというOpenAIの意見に概ね同意していました。

私はBig Modelsの責任者の一人と議論しましたが、そのとき彼は、幻覚を減らすための推論のポジティブな効果を特に強調しました。

しかし、R1のパフォーマンスは逆の結果を示している。

Vectaraのテストによると、確かにR1はV3よりも幻覚の発生率がかなり高く、R1の発生率は14.3パーセントで、前モデルのV3の3.9パーセントを大きく上回っている。これは「思考の連鎖」(CoT)と創造性の強化に直接関係している。R1は推論が得意で、詩や小説を書くことができるが、「副作用」として幻覚が多くなる。

R1における幻覚の増加にはいくつかの理由がある:

第一に、幻覚の基準テストは要約課題を用いており、要約能力はベースの大きなモデルの段階ですでにかなり成熟していることがわかっている。この場合、強化はかえって逆効果になる可能性があり、蚊を大砲で殴るようなもので、強く押しすぎると幻覚や捏造の可能性が高まる。

第二に、R1の長い思考鎖強化学習は、要約、翻訳、ニュース作成など、比較的単純だが事実が要求されるタスクに特に最適化されているわけではなく、むしろすべてのタスクにさまざまなレベルの思考を加えようとしている。

その透明な思考連鎖の出力からわかるように、単純な指示に直面したときでさえ、それをさまざまな角度から理解し、拡張するために多大な努力を払う。やりすぎはやりすぎで、このような単純作業を複雑にすることで、結果を遊びから遠ざけ、錯覚を増大させることができるのです。

また、DeepSeek-R1は、リベラルアーツタイプのタスクに対する強化学習トレーニング中に、モデルの創造性により多くの報酬を与えた可能性があり、その結果、モデルはコンテンツを生成する上でより創造的になり、真実から逸脱する可能性が高くなりました。

数学とコードについては、R1の監督シグナルは、これらのトピックのゴールドスタンダード(問題集の標準的な解答やコードのテストケース)から来ていることがわかっています。リベラルアーツタスクの良し悪しについては、V3またはV3の報酬モデルを利用しており、現在のシステムの好みが創造性を奨励するものであることは明らかです。

また、ユーザーからのより多くのフィードバックは、やはり見られる創造性を奨励し、評価します。特に、大きなモデルは絹のように滑らかで、イリュージョンを認識することはより難しいので、一般の人々はイリュージョンの認識には敏感ではありません。ほとんどの最前線の開発者にとって、ユーザーからのこのようなフィードバックは、ビッグモデル空間における最大の頭痛の種の1つである「錯覚」に対処するよりも、創造性を高めることに取り組むよう促す傾向があります。

具体的には、技術的な観点から見ると、R1は単純なユーザー指示に長い思考の連鎖を自動的に追加し、単純明快なタスクを複雑にしてしまいます。

単純な指示は、繰り返し理解され、異なる視点から拡張される(CoTの思考の連鎖は、「リトルナインティナイン」のようなもので、指示に従うときのエンティティの内部モノローグである)。思考の連鎖は、答えを生成する前に自己回帰確率モデルの条件部分を変化させ、最終的な出力に当然影響を与える。

V3モデルとの違いは以下の通り:

V3:クエリ ---〉答え

R1:クエリ+CoT ---〉答え 要約や翻訳など、V3がすでにうまく機能しているタスクでは、思考の連鎖を長く操ることで、逸脱や遊びが生じる可能性がある。幻覚の温床となる。

3.大型モデルの幻覚が起こる主な領域は?

R1の能力を「文系」と「理系」に分けると、数学や暗号などの「理系」では非常に論理的で、幻覚が比較的少ない。幻覚も比較的少ない。

しかし、言語的創造性の分野、特に現在テストされている要約課題では、幻覚の問題がより顕著である。これはむしろ、R1言語の創造性が爆発的に高まったことによる副作用である。

o1よりもさらに、R1の最も驚くべき功績は、数学とコード推論を言語創造領域にまで完全に拡張することに成功し、特に中国語能力において秀でていることである。インターネット上には、数え切れないほどの素晴らしいR1の章が出回っている。文章を書くという分野では、明らかに全人類の99%を凌駕しており、文学部の大学院生や中国学の教授でさえ賞賛している。

しかし、要約をさせるという、本来は非常に簡単な作業なのですが、少し「遊び」を与えなければならず、その結果、原文の一部を「でっち上げる」ことが簡単にできてしまうのです。私は前に言ったように、これはその "リベラルアーツ "が強すぎる、少し "あまりにも多くの力 "です。

推論の強化と幻覚の間には微妙な関係がある。

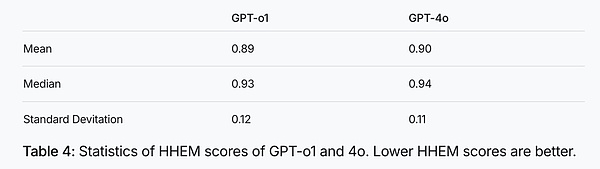

これらは単純な正負の相関関係ではなく、GPTファミリーの推論モデルo1のHHEMスコアの平均値と中央値は、その汎用モデルであるGPT-4oのそれよりも低い(下のグラフ参照)。しかし、R1とその基本モデルV3を比較すると、推論強化の追加後に幻覚が有意に増加することが再びわかった。

図:GPT-o1と4oのHHEMスコア統計、HHEMスコアが低いほど幻覚

台座モデルと比較すると、o1は幻覚を低下させ、R1は幻覚を増加させた。思考の連鎖を強引に推し進めすぎたことによると思われる。

フォロワーであるR1は、CoTのエンパワーメントを数学やコードから言語や文章作成に移すことに成功したが、その副作用として、R1は特に「既成概念にとらわれない思考」が好きで、簡単な命令を与えると、いろいろなことを思いつき、思考の連鎖が世界を3周することもある。

このことは、R1が創造性を高める過程で、必然的に「錯覚」という創造性の付随物が加わることを示しているようだ。

言語スキルは、実際には、詩や小説を書くような高度な創造性を必要とするものと、ジャーナリズム、翻訳、要約のような高度な真実性を必要とするものの2つに分類することができる。

これは、古くからある中国のことわざ「信達雅」を思い出させます。人々が優雅さのために信仰を犠牲にする例はたくさんあり、文学における誇張という修辞法は、その重要な道具であり例である。また、魯迅が推進した「硬訳」のように、「信頼性」のために「優雅さ」を犠牲にした前例もある。

私たち人間は、この点では常にダブルスタンダードであるが、心の中にいつでも切り替えられるスイッチを持っていることは興味深い。小説や映画を見るときは、創作的なほうにスイッチを切り替え、詳細が真実かどうかはまったく気にしないが、ニュースチャンネルに切り替えたとたん、私たちは虚偽に対してゼロの許容範囲を持つようになる。

4.究極の難問:どうすればビッグモデルを創造的かつ幻覚的でないものにできるのか?

人は、論理が明確で自明と思われるもの、そして詳細なものを信じる傾向がある。多くの人々は、R1の創造性に驚嘆しながらも、今ではこの幻覚現象に少しずつ気づき始め、警戒するようになっている。しかし、より多くの人々がまだR1が与えてくれる創造性に畏敬の念を抱いており、モデリングによる幻覚に対する一般の人々の認識を高める必要がある。

警戒を怠らない:大物モデルの言うことをすべて信じてはいけない。特に気をつけよう。

クロスチェック:重要な詳細については、ネットでソースを確認したり、周囲の専門家に聞いたりして、主張が一貫しているかどうかを確認する。

誘導モデル:質問には、「原文に忠実にしてください」、「事実を確認してください」など、いくつかの修飾語を加えることができる。、そうすることでモデルを幻滅させないように導くことができる。

検索:質問が多いユーザー、特にニュースや時事問題については、DeepThinkボタン(押すとR1スローシンキングモードになる)に加えて、もう1つのボタンである検索を押すことを忘れないでください。

ネットワーク検索の追加により、幻想を効果的に減らすことができます。いわゆるRAG(retrieval augmented generation)のような検索はアドオン・データベースであり、追加されたデータはモデル自身の詳細に対する無知を補うのに役立つ。

創造性を楽しむ:もしあなたが必要としているのがインスピレーションや創造性であれば、大きなモデルの錯覚はあなたを驚かせるでしょう。

大きなモデルの幻想を「可能性のパラレルワールド」だと考えてください。小説家が小説を書くように、それはフィクションでありながら、一種の「芸術的現実」でもあるのです。人生より高く、人生から。ビッグモデルは、データから生まれ、データよりも高い。ビッグモデルは、データベースの対象である単一の事実ではなく、知識と常識の体を圧縮する。

実際、ビッグモデルの幻想は、それが「でっち上げ」であるということだが、それは膨大な量の知識や法則を学習した上で「でっち上げ」ている。だから、その幻想は、しばしばランダムではなく、「本質的な合理性」を持っており、滑らかで継ぎ目のない、本物のような虚偽であるが、同時にまた、より混乱させる。友人の大きなモデルとの最初の接触は、特に注意する必要があり、だまされない。

平均的なユーザーにとっては、錯覚の特徴を理解することが重要です。例えば、「長江の長さはどのくらいか」というような百科事典的な質問をした場合、十分な情報の冗長性があり、これらの事実はモデルのパラメータに刻まれているため、大きなモデルは間違いを犯すことはありません。しかし、未知の川や架空の川の長さについて質問すれば、モデルは「もっともらしい否認」メカニズムを作動させて、それをでっち上げるだろう。

人間の言語自体が錯覚の温床であるとも言える。

言語によって、人間は神話、宗教、国家、企業、通貨など、実在しない概念や、理想や信念といった形而上学的なイデオロギーを作り出すことができるようになった。フレーリーは『人類史』の中で、文明における幻想の基本的な役割を強調している。言語の創造は、人間の幻想(「物語」)能力を強化した。幻想は文明の触媒である。人間は「嘘をつく」ことができる唯一の存在である--LLMを除いては。

将来、大きなモデルを創造的かつ幻覚的でなくする方法はあるのでしょうか?

これは間違いなく、AIマクロモデリングにおける「究極のパズル」の1つです!

より細かいトレーニング:トレーニング中、異なるタイプのタスクは異なる方法で扱われます!

モデルがいつ「正直」になり、いつ「手放す」かを知るようにする。

この葛藤は、タスクの嗜好を微調整(finetune)および/または強化(rl)することで、緩和することができます。要約、リライト、翻訳、レポートなどのタスクは、特別な注意とバランスが必要です。

具体的には、R1のトレーニングパイプラインは、微調整1、強化1、微調整2、強化2の4つのプロセスで構成されています。 強化2は、主に人間の嗜好に沿った強化です。このプロセスは、創造性と忠実性という点で、現時点では前者に傾いているようだ。おそらく、より重要なのは、第3段階での微調整2における異なるタスクに対する制約を強化することであり、例えば、ブートストラップ忠実でプレーンな結果に要約監督データを追加することである。

ルーティング:将来的には、タスクのタイプに応じて、異なるモデルが異なるタスクを処理するようにアレンジする「スケジューラー」があるかもしれません。

たとえば、単純なタスクはV3やコールツールに与えられ、低速で複雑なタスクはR1に与えられるでしょう。

たとえば、演算タスクを認識した場合、演算を行うための単純なコードを書くことができ、これは電卓を呼び出すことと同じです。昨日、9桁の掛け算をテストしてみたが、R1は3分以上考え、一歩一歩推論を分解しながら、通り道にプリントアウトできるような思考の連鎖を見せた。最終的に答えは正しかったが、時間がかかりすぎる算数の問題に、関数コールを使わず、いわゆるテスト・タイム・コンピュート(CoT)の思考連鎖を使っても意味がない。1行の計算コードでできることに対して、明示的な推論を行うために多くの計算資源とトークンを消費する必要はありません。

これらは、特にエージェントの時代において予測可能なルーティングです。

R1 CoTはすべてを行う必要はありませんし、錯覚の問題に加えて、資源の浪費であり、環境にも優しくありません。

<。

Alex

Alex

Alex

Alex Anais

Anais Joy

Joy Weatherly

Weatherly Joy

Joy Anais

Anais Alex

Alex Weatherly

Weatherly Miyuki

Miyuki Weiliang

Weiliang