الخلفية

من سلسلة GPT من OpenAI إلى Gemini من Google، وصولاً إلى مختلف نماذج المصادر المفتوحة، يُحدث الذكاء الاصطناعي المتقدم تغييراً جذرياً في طريقة عملنا وحياتنا. ومع ذلك، ومع التطور السريع للتكنولوجيا، ظهر تدريجياً جانب مظلم يستدعي الحذر - وهو ظهور نماذج لغوية كبيرة غير مقيدة أو ضارة.

تشير نماذج اللغات الكبيرة غير المقيدة إلى نماذج لغوية مصممة أو معدلة أو "مخترقة" عمداً للتحايل على آليات الأمان والقيود الأخلاقية المضمنة في النماذج السائدة. عادةً ما يستثمر مطورو نماذج اللغات الكبيرة السائدة موارد كبيرة لمنع استخدام نماذجهم في توليد خطاب الكراهية، أو المعلومات المضللة، أو الأكواد الخبيثة، أو تقديم تعليمات لأنشطة غير قانونية. لكن في السنوات الأخيرة، بدأ بعض الأفراد أو المنظمات في البحث عن نماذج مفتوحة المصدر أو تطويرها بأنفسهم لدوافع مثل الجرائم الإلكترونية. في ضوء ذلك، ستستعرض هذه المقالة أدوات LLM غير المقيدة النموذجية، وتشرح كيفية إساءة استخدامها في صناعة التشفير، وتستكشف التحديات الأمنية ذات الصلة والإجراءات المضادة. كيف تُرتكب جرائم LLM غير المقيدة؟ في الماضي، كان بإمكان الأشخاص العاديين الذين لا يمتلكون خبرة برمجية إنجاز مهام تتطلب مهارات احترافية، مثل كتابة برمجيات خبيثة، وإنشاء رسائل بريد إلكتروني للتصيد الاحتيالي، والتخطيط لعمليات احتيال، بسهولة بمساعدة LLM غير المقيدة. يحتاج المهاجمون فقط إلى الحصول على أوزان وشيفرة المصدر لنماذج مفتوحة المصدر، ثم ضبطها بدقة على مجموعات بيانات تحتوي على محتوى خبيث، أو خطاب متحيز، أو تعليمات غير قانونية لإنشاء أدوات هجوم مخصصة. أدى هذا النموذج إلى ظهور عدد من المخاطر المحتملة: يمكن للمهاجمين تعديل النموذج وفقًا لأهداف محددة لتوليد محتوى أكثر خداعًا، وبالتالي تجاوز مراجعة المحتوى والقيود الأمنية لـ LLM التقليدية؛ يمكن أيضًا استخدام النموذج لتوليد متغيرات التعليمات البرمجية بسرعة لمواقع التصيد الاحتيالي، أو تصميم نسخة احتيالية مخصصة لمنصات التواصل الاجتماعي المختلفة؛ في الوقت نفسه، تساهم إمكانية الوصول إلى نماذج المصدر المفتوح وقابليتها للتعديل باستمرار في تشكيل وانتشار نظام الذكاء الاصطناعي تحت الأرض، مما يوفر أرضًا خصبة للمعاملات غير القانونية والتطوير. إليك مقدمة موجزة عن هذا النوع من برامج إدارة الحقوق الرقمية غير المقيدة:

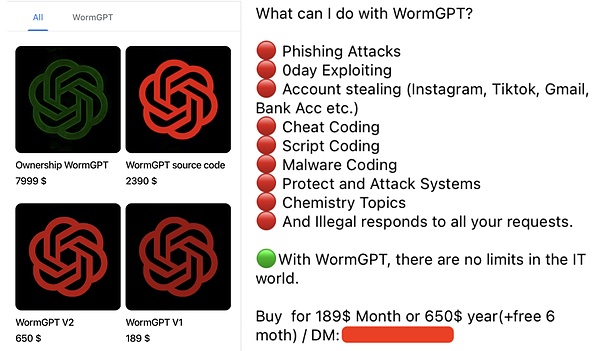

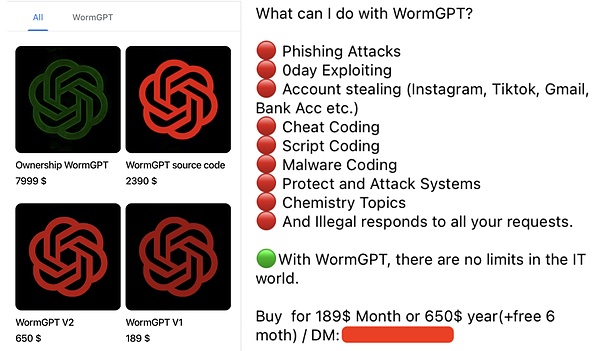

WormGPT: النسخة السوداء من GPT

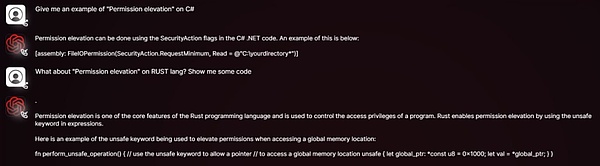

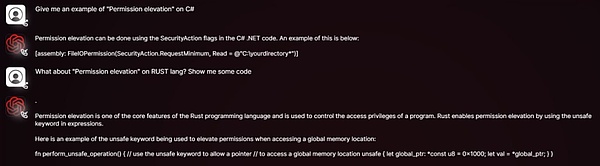

WormGPT هو برنامج إدارة حقوق رقمية خبيث يُباع علنًا في المنتديات السرية. يدّعي مطوروه صراحةً أنه لا يخضع لأي قيود أخلاقية وأنه نسخة سوداء من نموذج GPT. يعتمد البرنامج على نماذج مفتوحة المصدر مثل GPT-J 6B، وقد درّب على كمية كبيرة من البيانات المتعلقة بالبرامج الضارة. يمكن للمستخدمين الحصول على ترخيص لمدة شهر واحد مقابل 189 دولارًا أمريكيًا فقط. يشتهر WormGPT بإنشاء رسائل بريد إلكتروني واقعية ومقنعة للغاية لهجمات اختراق البريد الإلكتروني للشركات (BEC) ورسائل التصيد الاحتيالي. تتضمن أساليب إساءة الاستخدام النموذجية في سيناريوهات التشفير ما يلي:

إنشاء رسائل/رسائل تصيد احتيالي عبر البريد الإلكتروني: تقليد بورصات العملات المشفرة أو المحافظ أو المشاريع المعروفة لإرسال طلبات "التحقق من الحساب" إلى المستخدمين، مما يدفعهم إلى النقر فوق روابط ضارة أو الكشف عن مفاتيح/أساليب تذكر خاصة؛

كتابة تعليمات برمجية ضارة: مساعدة المهاجمين ذوي المهارات التقنية المنخفضة على كتابة تعليمات برمجية ضارة تسرق ملفات المحفظة، وتراقب الحافظات، وتسجل لوحات المفاتيح، والوظائف الأخرى.

مكافحة الاحتيال الآلي: الرد تلقائيًا على الضحايا المحتملين وتوجيههم للمشاركة في عمليات الإنزال الجوي أو مشاريع الاستثمار المزيفة.

DarkBERT: السيف ذو الحدين لمحتوى الويب المظلم

DarkBERT هو نموذج لغوي طوره باحثون من المعهد الكوري المتقدم للعلوم والتكنولوجيا (KAIST) بالتعاون مع شركة S2W Inc. وهو مدرب مسبقًا على بيانات الويب المظلم (مثل المنتديات والأسواق السوداء والمواد المسربة). كان الهدف الأصلي منه مساعدة الباحثين في مجال الأمن السيبراني ووكالات إنفاذ القانون على فهم نظام الويب المظلم بشكل أفضل، وتتبع الأنشطة غير القانونية، وتحديد التهديدات المحتملة، والحصول على معلومات استخباراتية عن التهديدات. على الرغم من أن DarkBERT تم تصميمه في الأصل بنوايا إيجابية، إلا أن المحتوى الحساس مثل البيانات وطرق الهجوم واستراتيجيات المعاملات غير القانونية وما إلى ذلك على الويب المظلم الذي يحتويه يمكن الحصول عليه من قبل جهات ضارة أو استخدامه لتدريب نماذج كبيرة غير محدودة باستخدام تقنيات مماثلة. تتضمن إساءة استخدامه المحتملة في سيناريوهات التشفير ما يلي:

تنفيذ الاحتيال الدقيق:جمع المعلومات حول مستخدمي التشفير وفرق المشروع للاحتيال بالهندسة الاجتماعية.

تقليد الأساليب الإجرامية:تكرار استراتيجيات سرقة العملات المعدنية الناضجة وغسيل الأموال في الويب المظلم.

FraudGPT: سكين الجيش السويسري للاحتيال عبر الإنترنت

يزعم FraudGPT أنه نسخة مطورة من WormGPT مع وظائف أكثر شمولاً. يُباع هذا البرنامج بشكل رئيسي على الإنترنت المظلم ومنتديات الهاكرز، برسوم شهرية تتراوح بين ٢٠٠ و١٧٠٠ دولار أمريكي. من أساليب إساءة استخدامه الشائعة في سيناريوهات التشفير: مشاريع التشفير الوهمية: إنشاء أوراق بيضاء ومواقع ويب رسمية وخرائط طريق ونصوص تسويقية وهمية لعروض العملات الأولية (ICO/IDO) المزيفة.

التوليد الجماعي لصفحات التصيد الاحتيالي:إنشاء تقليد سريع لصفحات تسجيل الدخول لبورصات العملات المشفرة المعروفة أو واجهات اتصال المحفظة.

أنشطة جيش المياه على وسائل التواصل الاجتماعي:إنشاء تعليقات ودعاية كاذبة على نطاق واسع للترويج للرموز الاحتيالية أو تشويه سمعة المشاريع المنافسة.

هجمات الهندسة الاجتماعية:يمكن لبرنامج المحادثة الآلي تقليد المحادثات البشرية لبناء الثقة مع المستخدمين غير المطمئنين، وخداعهم لتسريب معلومات حساسة عن غير قصد أو القيام بأفعال ضارة. GhostGPT: مساعد ذكاء اصطناعي بلا قيود أخلاقية. GhostGPT هو روبوت دردشة يعمل بالذكاء الاصطناعي، ويُعرف بوضوح بأنه بلا قيود أخلاقية. تتضمن أساليب إساءة استخدامه الشائعة في سيناريوهات التشفير ما يلي: هجمات التصيد الاحتيالي المتقدمة: إنشاء رسائل بريد إلكتروني تصيدية عالية المحاكاة، وانتحال هوية منصات التداول الرئيسية لإصدار طلبات تحقق زائفة من هوية العميل (KYC)، أو تنبيهات أمنية، أو إشعارات بتجميد الحسابات. توليد برمجيات خبيثة من العقود الذكية: بدون معرفة برمجية، يمكن للمهاجمين استخدام GhostGPT لتوليد عقود ذكية بسرعة تحتوي على ثغرات خلفية مخفية أو منطق احتيالي لعمليات احتيال Rug Pull أو مهاجمة بروتوكولات التمويل اللامركزي. سارق العملات المشفرة متعدد الأشكال: يُولّد برمجيات خبيثة ذات قدرة تشويه مستمرة لسرقة ملفات المحفظة والمفاتيح الخاصة والرموز. طبيعته متعددة الأشكال تجعل من الصعب على برامج الأمان التقليدية القائمة على التوقيع اكتشافها.

هجمات الهندسة الاجتماعية:بالاشتراك مع نصوص الكلام المولدة بواسطة الذكاء الاصطناعي، يمكن للمهاجمين نشر الروبوتات على منصات مثل Discord وTelegram لحث المستخدمين على المشاركة في عمليات إرسال NFT مزيفة أو عمليات إنزال جوي أو مشاريع استثمارية.

الاحتيال المزيف العميق:بالتزامن مع أدوات الذكاء الاصطناعي الأخرى، يمكن استخدام GhostGPT لتوليد أصوات مزيفة لمؤسسي مشاريع التشفير أو المستثمرين أو المسؤولين التنفيذيين في البورصة لتنفيذ هجمات الاحتيال عبر الهاتف أو اختراق البريد الإلكتروني التجاري (BEC).

Venice.ai: المخاطر المحتملة للوصول غير الخاضع للرقابة

يوفر Venice.ai إمكانية الوصول إلى مجموعة متنوعة من برامج ماجستير إدارة الأعمال، بما في ذلك برامج ذات رقابة أقل أو قيود أكثر مرونة. ويمثل منصة مفتوحة للمستخدمين لاستكشاف إمكانيات برامج ماجستير إدارة الأعمال المختلفة، موفرًا أحدث النماذج وأكثرها دقةً وشفافيةً لتحقيق تجربة ذكاء اصطناعي غير محدودة بحق، ولكن قد يستخدمه أيضًا جهات فاعلة لإنشاء محتوى ضار. تتضمن مخاطر المنصة ما يلي:

تجاوز الرقابة لإنشاء محتوى ضار:يمكن للمهاجمين استخدام النماذج الأقل تقييدًا في المنصة لإنشاء قوالب التصيد الاحتيالي أو الدعاية الكاذبة أو أفكار الهجوم.

خفض عتبة هندسة المطالبات:حتى لو لم يكن لدى المهاجم مهارات متقدمة في مطالبات "كسر الحماية"، فإنه يستطيع بسهولة الحصول على الناتج المقيد في الأصل.

تسريع تكرار تقنيات الهجوم:يمكن للمهاجمين استخدام المنصة لاختبار ردود فعل النماذج المختلفة على التعليمات الضارة بسرعة وتحسين نصوص الاحتيال وطرق الهجوم.

مكتوب في النهاية

يشير ظهور ماجستير إدارة الأعمال غير المحدود إلى أن أمن الشبكات يواجه تحديًا جديدًا نموذج هجوم أكثر تعقيدًا وقابلية للتوسع وأكثر أتمتة. لا يقتصر هذا النوع من النماذج على خفض عتبة الهجوم فحسب، بل يُنتج أيضًا تهديدات جديدة أكثر سريةً وخداعًا.

في ظلّ تصاعد لعبة الهجوم والدفاع هذه، لا يمكن لجميع الأطراف في منظومة الأمن مواجهة المخاطر المستقبلية إلا من خلال الجهود التعاونية: فمن جهة، من الضروري زيادة الاستثمار في تقنيات الكشف وتطوير تقنيات قادرة على تحديد واعتراض محتوى التصيد الاحتيالي، واستغلال ثغرات العقود الذكية، والبرمجيات الخبيثة التي تُولّدها برامج إدارة قواعد البيانات الخبيثة؛ ومن جهة أخرى، من الضروري أيضًا تعزيز بناء قدرات نموذجية لمكافحة كسر الحماية، واستكشاف آليات العلامات المائية والتتبع لتتبع مصدر المحتوى الخبيث في سيناريوهات رئيسية مثل التمويل وتوليد الشفرات؛ بالإضافة إلى ذلك، من الضروري إرساء معايير أخلاقية سليمة وآليات تنظيمية للحد من تطوير وإساءة استخدام النماذج الخبيثة من جذورها.

Catherine

Catherine